Ich höre und lese sehr häufig die Forderung nach einem vernetzten Denken der Menschen. Wir können unsere Problemstellungen in einer zunehmend vernetzten Welt nur durch vernetztes Denken in den Griff bekommen. Eine Studie der Boston Consulting Group aus dem Jahre 2002 (Dokument zufügen) belegt diese These.

Das ist aber nur die eine Seite der Medaille. Wir wissen oder glauben zu wissen, dass wir vernetzt denken müssen, um die Komplexität der heutigen vernetzten Welt zu handhaben. Aber können wir überhaupt vernetzt denken? Aus dem Titel dieses Posts wird meine Sicht bereits klar. Wir können es (derzeit) nicht. Aber keine Angst, denn das ist auch gar nicht notwendig. Warum? Das möchte ich jetzt zeigen.

Was ist eigentlich vernetztes Denken?

Nicht nur die oben angeführte Studie der BCG zeigt die Wichtigkeit des vernetzten (ganzheitlichen oder auch systemischen) Denkens auf. Hans Ulrich hat bereits 1985 für das vernetzte Denken plädiert. Natürlich darf man an dieser Stelle auch den Vater des vernetzten Denkens, Frederic Vester, nicht vergessen. In vielen seiner Ausarbeitungen, nennen möchte ich hier sein Buch Die Kunst vernetzt zu denken, hat er das vernetzte Denken zum Thema gemacht, die Notwendigkeit herausgestellt und Methoden dargelegt, wie vernetzt gedacht werden kann.

Aber was bedeutet eigentlich vernetzt zu denken? Im Unterschied zum klassischen linearen Denken wird beim vernetzten Denken in Kreisläufen oder Rückkopplungen gedacht. Das bedeutet, dass was Ursache ist kann auch wieder Wirkung sein und umgekehrt. Ein weiterer wichtiger Unterschied ist noch zu nennen. Es wird nicht nur in Kreisläufen sondern auch in Netzwerken gedacht. Damit postulieren wir ein ganzheitliches Denken. Diese Ganzheitlichkeit soll dem emergenten Verhalten komplexer Systeme Rechnung tragen, denn das Ganze ist mehr als die Summe seiner Teile. Wenn ich jetzt im nächsten Abschnitt zeigen werde, dass wir (derzeit) nicht vernetzt denken und es (derzeit) auch nicht können, dann möchte ich eben genau auf dieses Denken in Netzwerken Bezug nehmen.

Wir DENKEN nicht vernetzt, …

Emergentes Verhalten komplexer Systeme ist für uns nicht erklärbar. Wir können nicht von dem Verhalten einzelner Teile eines komplexen Systems auf das Verhalten des gesamten Systems schließen. Diese Thematik ist in der Wissenschaft auch unter dem Begriff Skalierungsproblem bekannt, also allgegenwärtig. Das bedeutet, man kann Theorien, Wissen und Erkenntnisse nicht einfach von einer Mikroebene auf eine Makroebene 1:1 transformieren.

Was wird aber in allen Methoden des vernetzten Denkens, egal ob wir uns das Sensitivitätsmodell von Vester, die Know-Why Methode von Consideo, System Dynamics oder die Methode des ganzheitlichen Problemlösens von Gomez und Probst anschauen, getan? Das Problem wird zerlegt und dann wieder zusammengefügt. Das Zerlegen und Zusammenfügen geschieht in allen der Methoden unterschiedlich, weshalb auch die Befürworter der jeweiligen Methoden diesen Fakt nehmen und argumentieren weshalb die jeweilige Methode besser geeignet ist, um vernetzt denken zu können. Der Punkt ist aber, dass keine der Methoden uns Menschen vernetzt denken lässt, da wir in allen Methoden separieren und zusammenfügen. Und genau bei diesem Zusammenfügen liegt die Krux. Denn hier sind wir dem oben angesprochenen Skalierungsproblem aufgesessen. Zeigen möchte ich das exemplarisch am Erstellen der Einflussmatrix in Vesters Sensitivitätsmodell. Ich könnte aber auch jede andere Methode heranziehen. Beim Erstellen der Einflussmatrix werden die möglichen Wirkungen zwischen den Faktoren eines Systems in einer Matrix aufgelistet. Von jedem Faktor ausgehend wird gefragt wie groß die Wirkung auf den jeweils anderen Faktor bei seiner Änderung ist. Die Zahl “0” steht für keine Auswirkung. Die Zahl “1” für einen unterproportionalen, die “2” für einen proportionalen und die “3” für einen überproportionalen Effekt. Dann werden jeweils Aktiv- und Passivsummen aller Faktoren gebildet. Damit möchte man ermitteln, wie viel die Faktoren zu einem Änderungsverhalten beitragen (aktiv oder reaktiv) und in welchem Maße die Faktoren von Änderungen in dem System betroffen sind (kritisch oder puffernd). Ich hoffe Sie erkennen bereits die Skalierungsproblematik, die aus der Emergenz eines komplexen Systems folgt. Wir können nicht einfach aus dem Verhalten einzelner Faktoren auf das Gesamtverhalten schließen. Denn wenn wir das könnten, wovon wir beim Befolgen der Methoden ausgehen, hätten wir kein emergentes System mehr. Wir bräuchten dann wohl auch diese Methoden nicht mehr.

Vernetztes Denken ist also nur dann möglich wenn wir das zu untersuchende System stets im Ganzen betrachten. Bereits beim Betrachten und Analysieren von Teilsystemen oder Faktoren verlassen wir den Bereich der Vernetztheit.

… da wir es (derzeit) nicht können, …

Denken und Vernetzung schließen sich (derzeit) aus. Denn wie denken wir? Wir nehmen unsere Umwelt wahr, in dem wir Dinge der Umwelt mit Objekten gleich setzen. Wenn wir einen Tisch wahrnehmen, dann setzen wir diesen mit dem Objekt “Tisch” in uns gleich. Alle Denkprozesse in Bezug auf diesen Tisch vollführen wir mit dem Objekt “Tisch”. Würden wir das nicht tun, könnten wir gar nicht mit unseren natürlichen Zahlen rechnen. Die natürlichen Zahlen sind also eher “künstlich” als “natürlich”. Die Zahl “1” hätte für uns keinen Mehrwert, denn ALLES würde sich unterscheiden, was es ja in der Umwelt auch tut. Aber wir abstrahieren, wir separieren und fügen danach wieder zusammen, um die Dinge für uns handhabbar zu machen. Wir denken so, weil unsere Sprachen es nicht anders zulassen. Unsere Sprachen sind nämlich nicht vernetzt und kreiskausal. Wir setzen Buchstaben zu Wörtern, Wörter zu Sätze und Sätze zu Aufsätze etc. zusammen. Unsere Sprache beeinflusst unser Denken und umgekehrt. Details können Sie in zwei meiner Posts nachlesen (Unsere Sprache beschränkt unser Denken und Die Sprache als Linse).

Wir können nur wahrnehmen in dem wir fokussieren und entsprechend unterscheiden. Ohne Fokussierung und ohne Unterscheidung gibt es für uns keine Wahrnehmung. Also auch hier keine Vernetzung. Wir dürfen grundsätzlich nicht den Fehler machen, Separierung und Zusammenfügen anschließend als Vernetzung auszulegen, auch wenn dies in Rekursionen und Rückkopplungen geschieht, da wir, und das habe ich bereits ausgeführt, Theorien von der einen Metaebene einfach in eine höhere Metaebene transformieren. Das ist sehr gefährlich, weil wir dafür keine Legitimation haben. Hier prallen zwei ganz unterschiedliche Wissenschaftstheorien aufeinander: Science und Systemics. Detlef Mamrot hat diesen Unterschied sehr schön in seiner aktuellen Ausarbeitung zu Komplexität im Kapitel 3 ausgeführt.

… was aber auch nicht so schlimm ist, da wir vernetzt HANDELN können.

Jetzt habe ich bestimmt bei Anhängern des vernetzten Denkens (Ich war übrigens auch einer. Jetzt bin ich Anhänger des vernetzten Handelns), Wellen geschlagen. Nun möchte ich die Wogen wieder ein bisschen glätten. Die Emergenz hat uns einen Stachel versetzt, den ich nun wieder entfernen möchte.

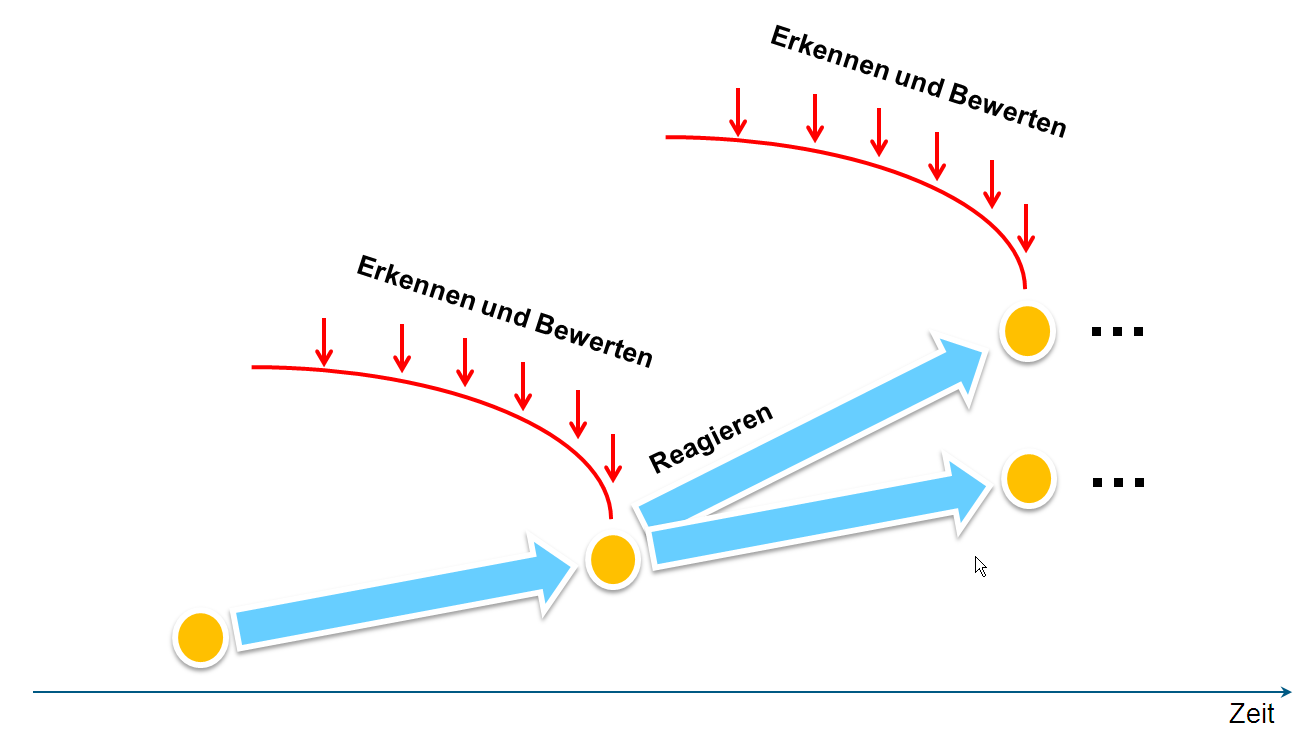

Wir können (derzeit) nicht vernetzt denken. Das ist auch nicht so wild. Denn unser Ziel ist es nicht vernetzt zu denken, sondern vernetzt zu handeln. Wir müssen nicht unbedingt vernetzt denken um vernetzt handeln zu können (Emergenz). Wir schaffen durch das Denken auf der Mikroebene auf der Makroebene eine höhere Qualität. Auf der Mikroebene herrscht noch keine Vernetztheit vor, auf der Makroebene schon. Genau für diesen Transfersind die von mir angesprochenen Methoden geeignet. Diesen Transfer möchte ich nun ein bisschen näher erläutern.

Ich teile uns Wissen oder auch Vermögen in 4 Kategorien ein.

- Unbewusstes Nichtwissen (Unvermögen)

- Bewusstes Nichtwissen (Unvermögen)

- Bewusstes Wissen (Vermögen)

- Unbewusstes Wissen (Vermögen)

Details zu diesen Arten habe ich einem Artikel verfasst. Ich möchte diese Kategorien am Beispiel “Auto fahren können” spiegeln. Meine beiden Kinder, derzeit 9 und 6 Jahre alt, können kein Auto fahren. Sie verspüren aber derzeit auch gar nicht das Verlangen, es lernen zu wollen. Es ist für sie kein Thema. Sie befinden sich diesbezüglich in Stufe 1, dem unbewussten Unvermögen. In absehbarer Zukunft allerdings werden sie sich diesem Unvermögen bewusst werden. Sie möchten es dann erlernen, da sie es benötigen. Dann befinden sie sich in Stufe 2, dem bewussten Unvermögen. Dann lernen sie das “Auto fahren”. Am Anfang ist es dann noch ein wenig holprig. Sie müssen sich beim Steuern des Autos über sehr viel bewusst werden, Bremsen, Gas geben, Schalten. Sie befinden sich in Stufe 3, dem bewussten Vermögen. Mit der Zeit geht das Steuern des Autos aber in Fleisch und Blut über. Vieles läuft dann unbewusst ab, ohne dass jede Bewegung, bevor sie ausgeführt wird, durchdacht wird. Das ist gerade in Gefahrensituationen wichtig, da es hier um schnelles Reagieren geht. Sie befinden sich dann in Stufe 4, dem unbewussten Vermögen.

Natürlich sind die Grenzen zwischen diesen Stufen nicht gradlinig, sondern eher schwammig. Des Weiteren laufen die Übergänge auch in Rekursionen ab, mal hin und mal wieder zurück, insbesondere in den Stufen 3 und 4. Es gibt hier aus meiner Sicht auch grundsätzlich keine Wertung. Stufe 4 ist also nicht besser als Stufe 3. Wir benötigen beide Stufen, um lebensfähig zu sein. In der Stufe 3 handeln wir rational. Wir denken bewusst. In der Stufe 4 handeln wir eher intuitiv.

Vielleicht fragen Sie sich, was das jetzt mit dem eigentlichen Thema zu tun hat? Ich komme jetzt darauf. Beim Durcharbeiten der Methoden befinden wir uns in Stufe 3. Wir kommunizieren, wir lesen, wir schreiben auf. Im Rahmen dieser Tätigkeiten denken wir nicht vernetzt, denn wir nutzen unsere Sprache. Das habe ich im vorigen Abschnitt gezeigt. Wir bauen dadurch Wissen auf, was uns in bestimmten Situation handeln lässt. Dann sind wir in Stufe 4.

Ich möchte kurz auf das Beispiel mit dem “Auto fahren können” zurückkommen. Ich hatte bereits des Öfteren brenzlige Situationen im Straßenverkehr zu meistern. Da habe ich einfach funktioniert und zwar vernetzt. Ich habe intuitiv gehandelt ohne jede Bewegung meines Körpers vorher genau zu durchdenken. Wenn mich danach Jemand fragte warum ich was in welcher Reihenfolge gemacht habe, konnte ich gar nicht in der Lage sein, dieses getreu zu schildern. Da diese Schilderung nur unvernetzt sein kann. Ich nutze unsere Sprache. Diese Fähigkeit beim Autofahren vernetzt handeln zu können habe ich mir durch das unvernetzte “Autofahren lernen” angeeignet. Wir erkennen hier die Emergenz.

Und hier sehe ich jetzt die Stärke der von mir angesprochenen Methoden. Es geht in diesen Methoden nämlich hauptsächlich um den Prozess des Lernens des vernetzten Handelns. Der PROZESS ist wichtig und die Ergebnisse, wie die Einflussmatrix oder das Wirkungsgefüge sind Abfallprodukte dieses Prozesses. Wie wir diese Fähigkeit genau erlernen, können wir wegen der Emergenz nicht erklären.

Fazit

Nur weil ich also postuliere, dass die herkömmlichen Methoden des vernetzten Denkens, uns Menschen nicht helfen vernetzt denken zu können, bedeutet es nicht automatisch, dass diese Methoden keinen Mehrwert liefern. Ganz im Gegenteil. Sie tragen in einem hohen Maße dazu bei, dass wir vernetzt handeln können.

Zum Ende noch eine kleine Bemerkung. Ich habe in meinen Sätzen stets das Wort “derzeit” in Klammern eingefügt, denn wir können derzeit nicht vernetzt denken. Es ist eine Standortbestimmung von mir aus heutiger Sicht. Können wir überhaupt irgendwann vernetzt denken? Keine Ahnung. Voraussetzung dafür ist aber eine vernetzte Sprache. Ich habe des Öfteren gehört, dass beispielsweise asiatische Sprachen nicht so linear aufgebaut sind wie unsere lateinischen. Können die Asiaten deshalb vernetzt denken? Ist das Ergebnis eines vernetzten Denkens besser als das eines unvernetzten Denkens? In beiden Fällen kann man die Fähigkeit entwickeln vernetzt zu handeln.

Ich spreche also nicht vom vernetzten Denken, sondern vom expliziten Modellieren und dem daraus folgenden vernetzten Handeln.

(2 Bewertung(en), Durchschnitt: 4.50 von 5)

(2 Bewertung(en), Durchschnitt: 4.50 von 5)

Loading...

Loading...

(2 Bewertung(en), Durchschnitt: 4.50 von 5)

(2 Bewertung(en), Durchschnitt: 4.50 von 5)