Sehr oft habe ich über die Bedeutung der Kybernetik für meine Reise des Verstehens nachgedacht und bin dabei zu der Erkenntnis gelangt, dass die Kybernetik einen zentralen Punkt einnimmt, wenn wir die Probleme der heutigen Zeit, wie die Umweltproblematik oder die Gesellschaftskrise, in den Medien eher als Finanzkrise bezeichnet, lösen wollen.

Inspiriert wurde ich bei meiner Ideenforschung von Stephen Toulmin, der in seinem Buch Kosmopolis. Die unerkannten Aufgaben der Moderne über die historische Entwicklungen des Humanismus und des Rationalismus berichtet und Schlussfolgerungen für das menschliche Leben in der Zukunft herleitet. Das Vorwort, Kapitel 1 und Kapitel 5 des Buches können sie in diesem Dokument nachlesen.

Aber natürlich haben mich auch die Erkenntnisse und Ideen Gotthard Günthers nicht unberührt gelassen. In seiner Vorlesung über Naturphilosophie zeichnet Günther die geschichtliche Entwicklung, startend mit den Anfängen der Religion bis hin zu den ersten wissenschaftlichen Errungenschaften, die auf rationalistische Denkweisen beruhen, nach.

Die Versöhnung: Eine erste Annäherung

Norbert Wiener, einer der Pioniere der Kybernetik, gibt eine aus meiner Sicht treffende Definition von Kybernetik wieder, wenn er sagt:

Kybernetik ist die Lehre von Regelung, Steuerung und Kommunikation im Lebewesen und in der Maschine.

Die Kybernetik hat als erste Wissenschaft angefangen, auf interdisziplinare Art und Weise Natur- und Geisteswissenschaften in einen Kontext zu setzen, denn sie versucht, Erkenntnisse die bezüglich toter Materie in den Naturwissenschaften gewonnen wurden, mit den Erkenntnissen bezüglich lebender Materie aus den Geisteswissenschaften zu verheiraten.

Geboren wurde der Ansatz der Kybernetik auf den Macy-Konferenzen. Zwischen 1946 und 1951 wurden unter dem Titel “Cybernetics. Circular Causal, and Feedback Mechanisms in Biological and Social Systems” insgesamt zehn Konferenzen unter der Schirmherrschaft der Josiah Macy, Jr. Foundation veranstaltet. Auf den Konferenzen wurde interdisziplinär nach einer universalen Theorie der Regulation, Steuerung und Kontrolle zu entwickeln versucht, die für Lebewesen wie für Maschinen, für ökonomische wie für psychische Prozesse, für soziologische wie für ästhetische Phänomene gleichermaßen gilt. Da diese Dikussionen interdisziplinär waren, war es unumstößlich, dass auch Vertreter verschiedener Wissenschaftsbereiche vertreten waren, beispielsweise aus den Bereichen Mathematik, Physik, Elektrotechnik, Psychologie, Neurophysiologie, Psychiatrie, Soziologie oder Anthroplogie.

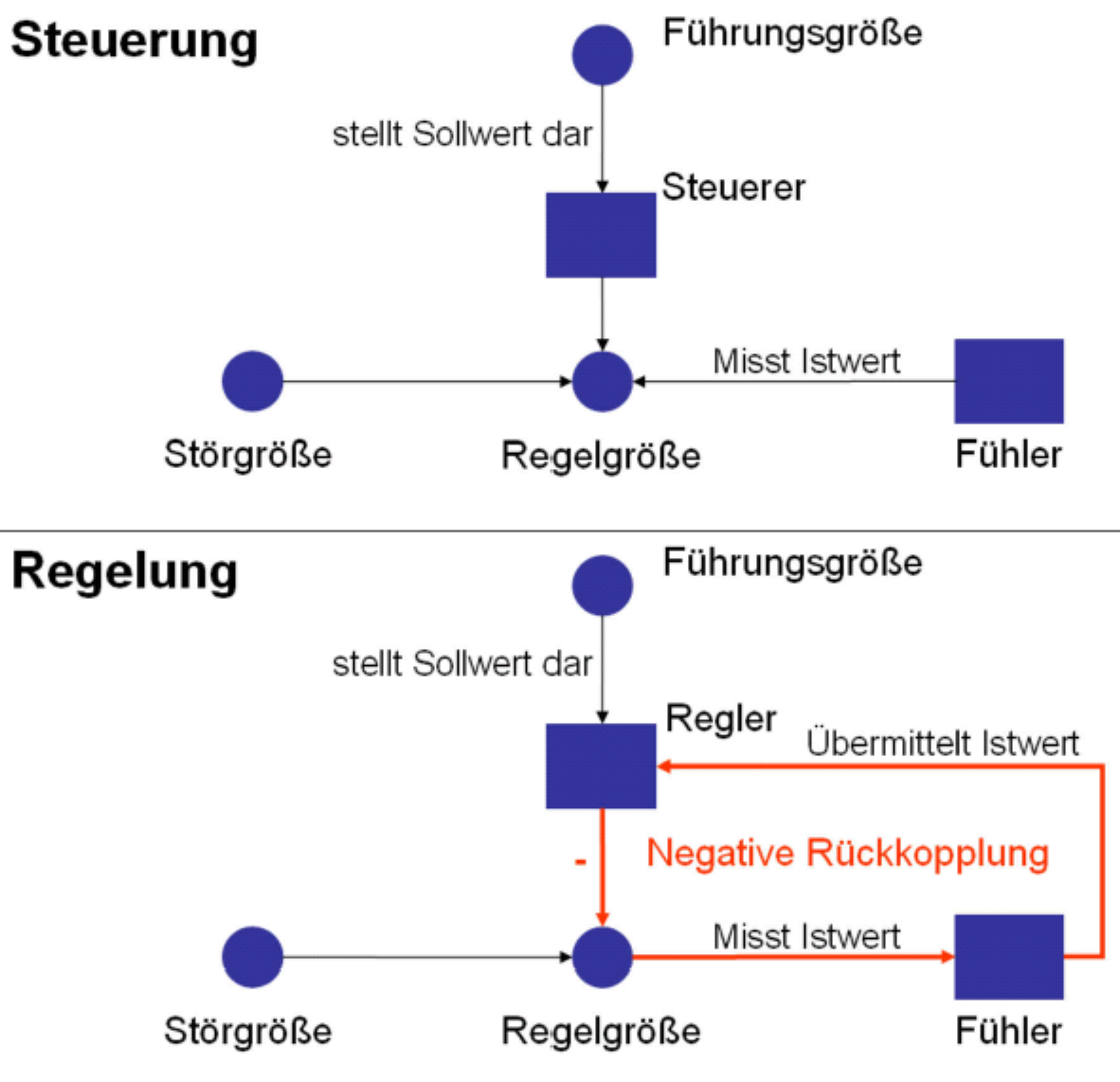

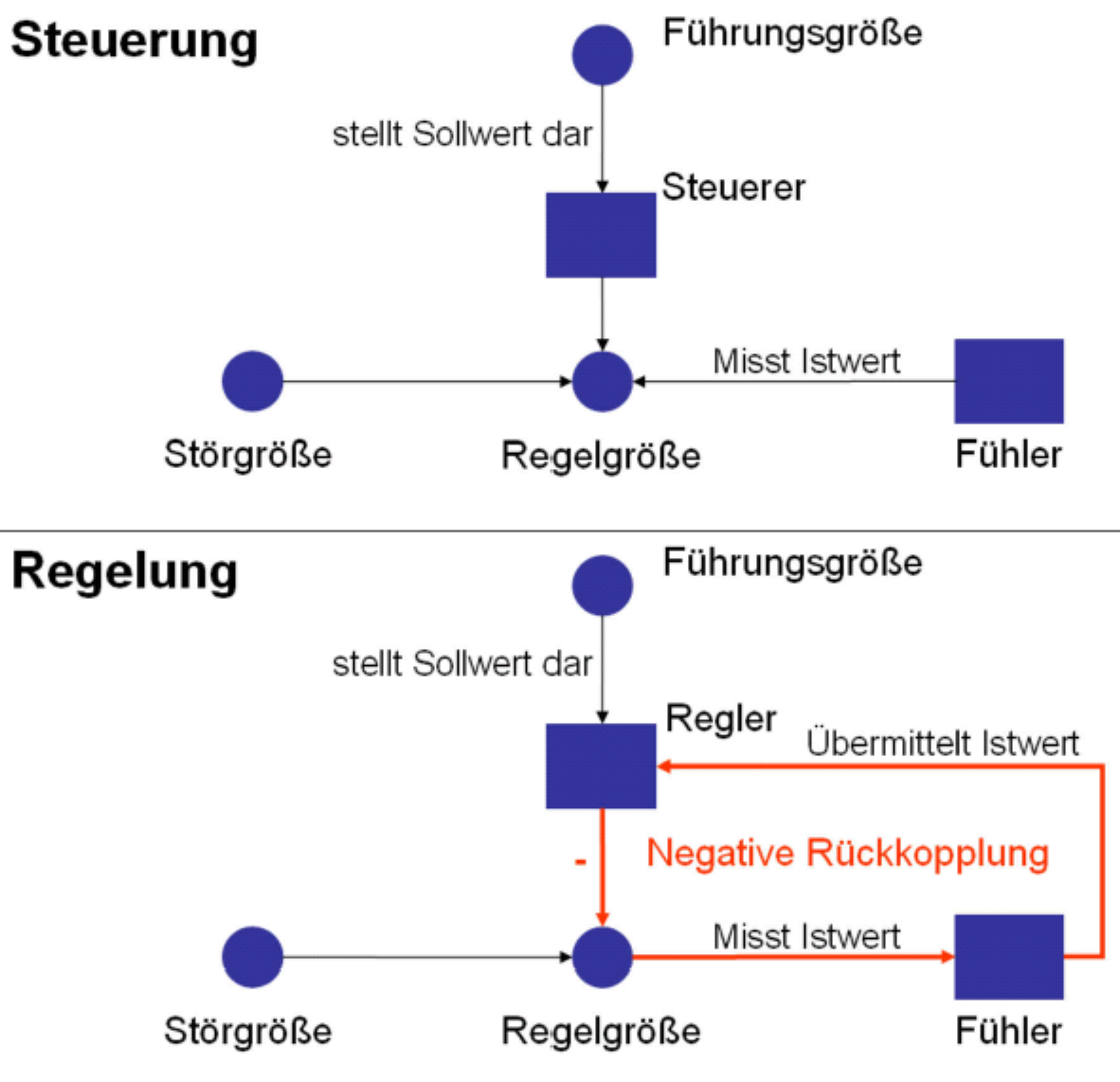

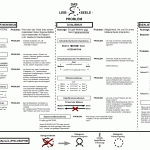

Kybernetik wird in Kybernetik erster und zweiter Ordnung unterschieden. Dazu möchte ich ein paar Worte verlieren, da diese Unterscheidung uns auf dem Weg zur Versöhnung zwischen dem Rationalen und dem Humanen voranbringt. Starten wir mit der Kybernetik erster Ordnung, stoßen wir auf die Begriffe Regelung und Steuerung, die wir schon von der Definition von Wiener her kennen. Beiden gemeinsam ist, dass ein bestimmtes System, nämlich das zu steuernde oder zu regelnde, einen bestimmten Zweck erfüllen soll, wodurch sich eine bestimmte Variable in gewünschter Weise verhalten soll. Der große Unterschied zwischen Steuerung und Regelung besteht nun darin, dass bei der Steuerung eine lineare Ursache-Wirkungsbeziehung vorliegt, was dazu führt, dass im Rahmen von Steuerung der erreichte Endzustand der zu steuernden Variable selbst bei starken Abweichungen vom gewünschten Verhalten oder Variablenwert ein endgültiger ist, also nicht mehr geändert wird. Es gibt also keinen regulierenden Mechanismus hinsichtlich der Abweichungen des Istwertes vom Sollwert. Der angesprochene regulierende Mechanismus wird auch als negative Rückkopplung bezeichnet. Die folgende Abbildung stellt diese Unterschiede graphisch dar.

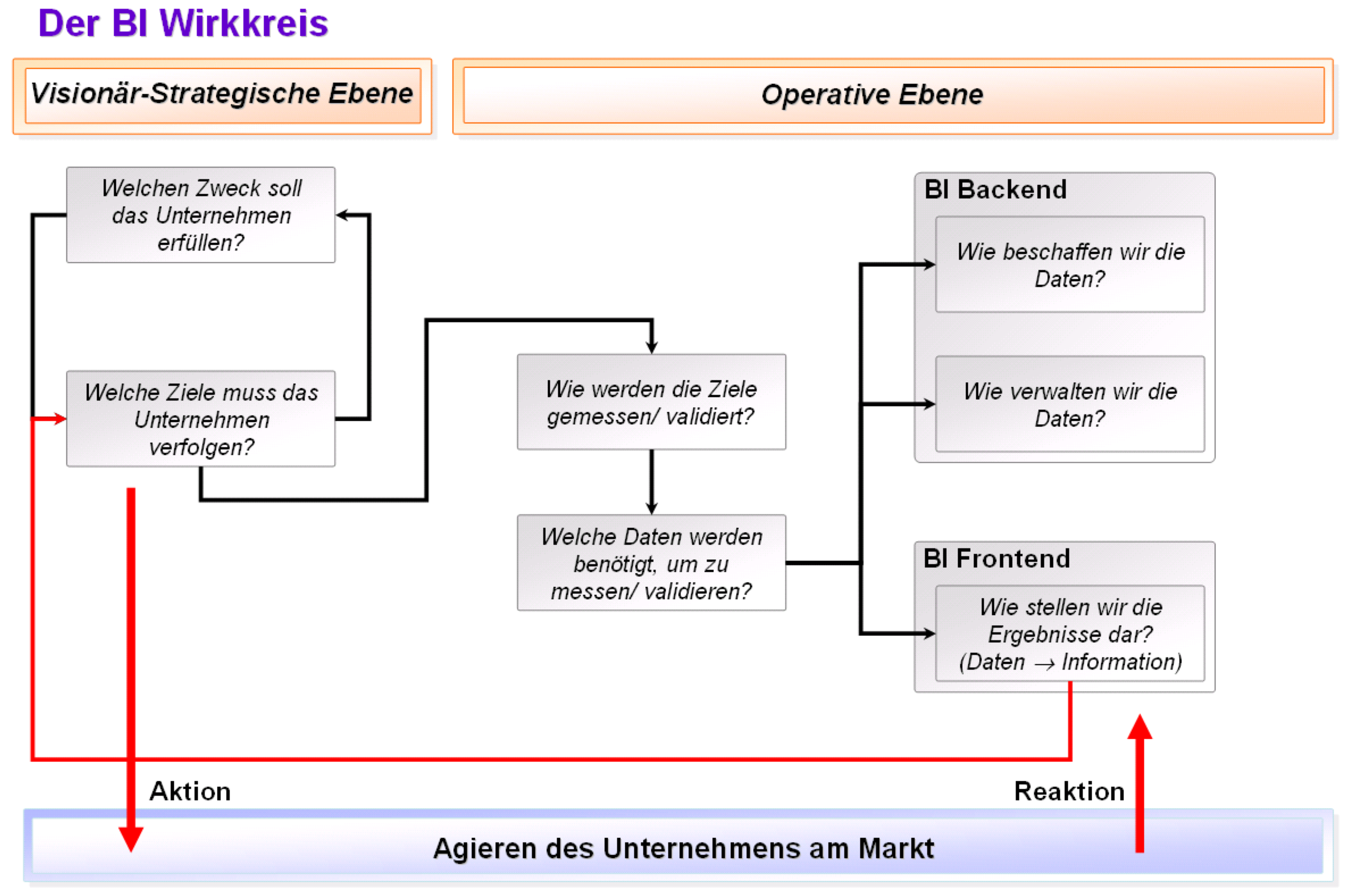

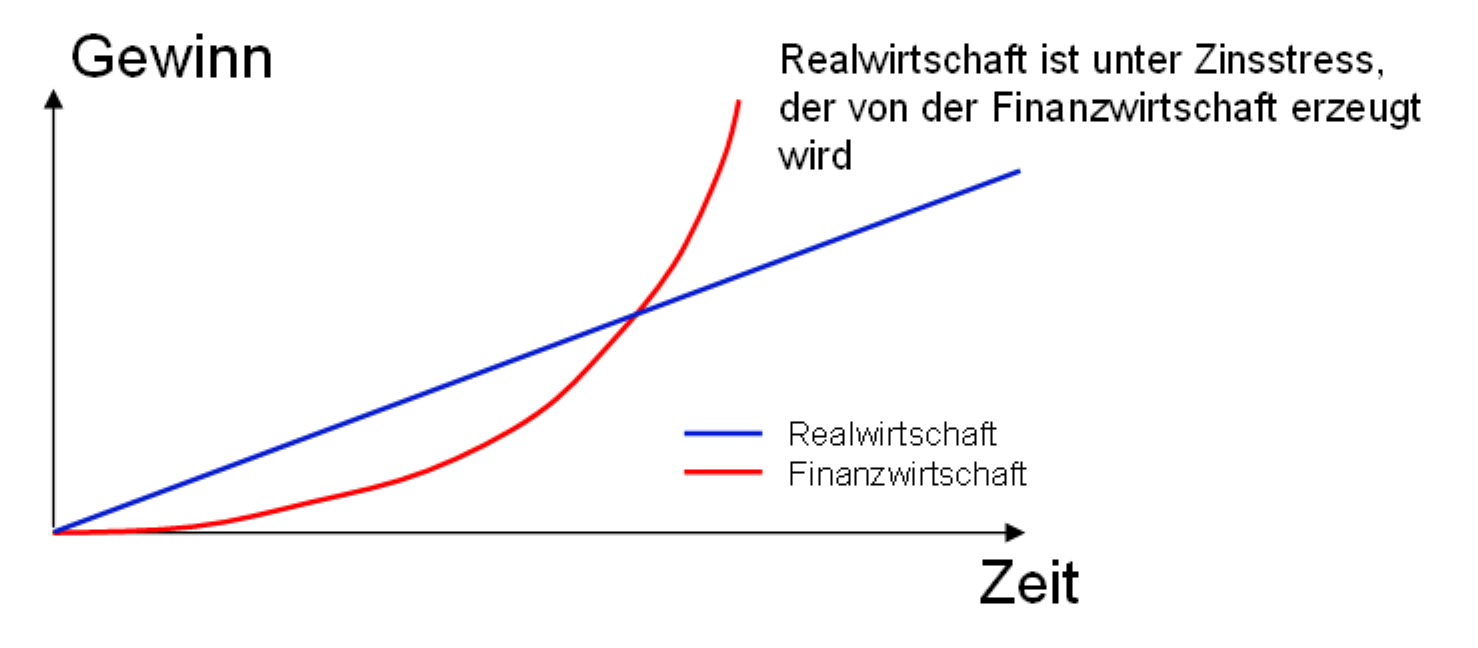

Aufgrund der fehlenden Justierung auf einen Zielwert ist es ersichtlich, dass ein irgendwie funktionierendes System, das kann ein Unternehmen aber auch eine Gesellschaft sein, nicht auf negative Rückkopplungen verzichten kann. Einige Teilsysteme eines Systems können vielleicht ausschließlich gesteuert werden. Rückkopplungen in Wirkungsschleifen von Systemen sind verantwortlich für nichtlineares Verhalten dieser Systeme. Denken Sie beispielsweise an den Zinseszins, der unsere Gesellschaft in eine Krise gestürzt hat. In diesem Beispiel reden wir nicht von einer negativen, sondern von einer positiven Rückkopplung. Die positive Rückkopplung lässt uns den Schwenk hin zur Kybernetik zweiter Ordnung vollführen.

Ausgangspunkt der bisherigen Betrachtung der Kybernetik erster Ordnung ist es, ein Ziel zu haben und dieses durch Regelung und Steuerung zu erreichen. Aber wie kann man erklären, dass häufig Ziele erreicht werden, die man nicht angestrebt oder auch nicht gedacht hat, die aber trotzdem als positiv für das Unternehmen zu bewerten sind? Bei der Kybernetik erster Ordnung wird das Erreichen einer Stabilität durch eine Kontrollinstanz in den Vordergrund gestellt. In einem rein rationalistisch geprägten System, sprich einem toten System wie einer Heizungsanlage, in welchem alle Komponenten bekannt sind, gibt es weniger Überraschungen. Fast alles ist berechenbar und zum großen Teil vorhersagbar. Ein Steuern und Regeln ist anwendbar. In humanistisch geprägten Systemen aber herrscht intrinsische Unsicherheit, keine exakte Analysierbarkeit und auch keine Vorhersagbarkeit. Es muss ein Paradigmenwechsel vollzogen werden hin zur Akzeptanz einer instabilen Dynamik von Entscheidungen. Bei der Kybernetik zweiter Ordnung werden die Prinzipien der Kybernetik erster Ordnung auf den Beobachter selbst angewendet. Der Beobachter muss als Teil des Kontextes, den er beobachtet, mitkonzeptualisiert werden. Hier stehen die beobachtenden Systeme und nicht mehr nur wie in der Kybernetik erster Ordnung die beobachteten Systeme im Fokus. Es sind nicht mehr nur stabilisierende negative Rückkopplungen im Fokus der Untersuchung, sondern auch verstärkende und aufschaukelnde positive Rückkopplungsprozesse, die unter anderem in Kommunikationsprozessen zwischen Lebewesen zu beobachten sind. Dadurch werden konzeptionelle Betrachtungsweisen bezüglich des Lernens von lebenden Systemen oder des Revidierens und Korrigierens von Zielen erst möglich.

Einen Einfluss des Nichtbeachtens von positiven Rückkopplungsschleifen erkennen wir beispielsweise in Planungsprozessen der heutigen Unternehmen. Planen bedeutet in den meisten Fällen stets von nur genau einer Zukunft auszugehen. Es existieren aber ganz viele mögliche und vorstellbare Zukunften. Es muss die Möglichkeit des Phantasierens und Simulierens bestehen, um diese möglichen Zukunften einzukalkulieren. Wenn heute geplant wird, wird der Blick ausschließlich auf die Vergangenheit gerichtet. Die Zukunft kann sich aber komplett anders entwickeln als die Vergangenheit. Beim Planen gehen wir mit dem Rücken voran in die Zukunft. Negative Rückkopplungsschleifen überwiegen und damit der Rationalismus.

Damit haben wir alle Elemente obiger Definition von Wiener beleuchtet und haben einen ersten Annäherungsversuch zwischen Rationalismus und Humanismus gewagt. Einen Nachtrag habe ich noch. Detaillierter betrachte ich die Kybernetik und die Einbettung in die Unternehmensführung in meinem noch in Arbeit befindlichen Buch Business Systemics. Warum sich Business Intelligence neu erfinden muss oder Heirat von Systemtheorie, Kybernetik und Business Intelligence. Sie können auch in meinem Rucksack nachschauen, wo ich die Managementkybernetik beleuchte.

Die Versöhnung: Eine zweite Annäherung

Ich habe mein Mathematikstudium im Jahre 1999 mit dem Diplom abgeschlossen, war also zu dieser Zeit durchweg rational-mechanistisch gerägt. Mein Credo war.

Alles was man nicht messen kann, kann man nicht kontrollieren. Alle Dinge, die wir wahrnehmen, müssen auch naturwissenschaftlich erklärbar sein.

Die Erkenntnisse der Naturwissenschaften beherrschten meine Denk- und Handelsweisen. Die emotional-humanistische Denkweise kam dann so im Jahre 2006 an die Oberfläche gespült, in dem Zuge nämlich da ich merkte, dass eben nicht alles naturwissenschaftlich erklärbar ist, was geschieht. Ich wusste zu diesem Zeitpunkt nur noch nicht, ob das daran liegt, dass wir nur noch mehr Wissen aufbauen müssen, um alle Phänomene erklären zu können oder ob diese im bekannten naturwissenschaftlichen Rahmen schlicht nicht erklärbar sind, so dass dieser erweitern werden müsste. Mir wurde dann relativ schnell klar, dass es um genau diese Erweiterung tatsächlich geht. Um das zu tun, muss man aber erst einmal nach der Linie suchen, die die rational-mechanistischen Denkweise, die aus den Naturwissenschaften stammt, von der emotional-humanistischen Denkweise, die aus den Geisteswissenschaften stammt, trennt. Hat man diese analysiert, kann die Versöhnung angegangen werden. Selbstverständlich spielte und spielt bei dem Aufsuchen dieser Trennlinie die Kybernetik eine ganz besondere Rolle.

Eine der vorherrschenden Fragestellungen der Historie, aber auch noch der heutigen Zeit, ist das Leib-Seele-Problem. Unter dem hier angeführten Link habe ich auch die nebenstehende Abbildung gefunden.

Die monoistischen Materialisten behaupten, es gäbe nur Materie, die monoistischen Idealisten behaupten, es gäbe nur den Geist. Hier haben wir wieder wie oben schon angesprochen eine ganz scharfe Trennung. Eine Versöhnung kann durch den Dualismus erfolgen, der von Beidem, Geist und Materie, ausgeht. Das Problem, welches im Rahmen des Dualismus immer noch nicht geklärt ist, ist wie Geist und Materie interagieren. Denn dass diese interagieren, wissen wir spätestens seit Werner Heisenberg, der postuliert hat, dass der isolierte Gegenstand prinzipiell keine beschreibbaren Eigenschaften besitzt. Denn beim Beschreiben von Phänomenen muss stets der Beobachter mit einbezogen werden (Kybernetik zweiter Ordnung). Denn Eigenschaften von Gegenständen sind auch im Beobachter enthalten, da es ja er ist, der beobachtet und beschreibt. Dazu möchte ich Ihnen ein Beispiel geben. Es ist mir des Öfteren vorgekommen, dass ich mir ein Fussballspiel ansehe und nach dem Spiel zu dem Schluss komme, dass die eine Mannschaft viel besser war als die andere, was dann von Freunden negiert wird. Wir haben das gleiche Spiel geschaut, kommen aber zu unterschiedlichen Meinungen. Ein Grund könnte sein, dass man für die eine Mannschaft mehr fiebert als für die andere. Das Ergebnis der Beobachtung ist also im Beobachter mit enthalten. Bei den ganzen Diskussionen bzgl. Idealismus versus Materialismus wird oft vergessen, dass beide Denkrichtungen auf dem selben Fundament gebaut sind. Es wird nämlich von Teilen ausgegangen, die nicht mehr weiter zu teilen sind und aus denen dann alles Weitere aufgebaut ist. Beim Materialismus sind es die Atome, beim Idealismus sind es die Seelen. Im Materialismus besteht alles aus toter Materie, aus Atomen, selbst die Menschen werden als aus Atomen zusammengesetzt angesehen. Alles Wissen, was also im Denkschema des Materialismus entwickelt wurde, sprich in den Naturwissenschaften, ist Wissen, welches ausschließlich toter Materie anwendbar ist.

Nur erkennt man diesen Fakt nicht, oder man will es nicht erkennen. Ganz besondere Bedeutung erlangt aber diese Erkenntnis im Bereich der Künstlichen Intelligenz. Im Forschungsgebiet der KI wird davon ausgegangen, dass man das menchliche Gehirn anhand seiner Einzelteile analysen und untersuchen, diese nachbauen und dann zusammensetzen kann. Das geht aber nicht. Dazu ein passendes Zitat von Gottfried Wilhelm Leibniz aus seiner Monadologie

Man muss im übrigen eingestehen, dass die Perzeption und was davon abhängt, durch mechanische Gründe, d.h. durch Gestalten und durch Bewegungen unerklärbar ist. Wollte man vorgeben, dass es eine Maschine gäbe, deren Struktur Denken, Empfinden und Perzeptionen haben lässt, könnte man dies unter Bewahrung derselben Proportionen vergrößert begreifen, so dass man in sie wie in eine Mühle hineintreten könnte. Dies gesetzt, würde man beim Besuch im Inneren nur einander stoßende Teile finden, niemals aber etwas, was eine Perzeption erklärt.

Eine Versöhnung zwischen Materialismus und Idealismus oder auch zwischen Naturwissenschaften und Geisteswissenschaften ist also notwendig, um auf dem Gebiet der Künstlichen Intelligenz durchschlagenden Erfolg haben zu können. Dabei kann die Kybernetik vermitteln.

Selbst in der Bildung muss diese Versöhnung erfolgen, was Gerald Hüther sehr plausibel in einem Interview im Rahmen der WDR5 Tischgespräche am 28.09.2011 ausführt. Er meint, dass wir Menschen noch viel zu sehr unserer Faszination für Maschinen erlegen sind und entsprechend auch das Lernen als zu mechanistisch begreifen wollen. Lernen darf aber nicht verglichen werden mit dem Muskelaufbau auf einer Hantelbank. Das Gehirn bildet sich nur unter Freude optimal aus, also wenn wir Menschen mit Herz und Engagement bei der Sache sind. Da sind wir in unseren Bildungseinrichtungen noch weit entfernt.

Ich glaube übrigens, dass wir Menschen in den Anfangsjahren unseres Lebens mit beiden Denkrichtungen versöhnt sind. Kinder lieben beispielsweise Märchen. In diesen sind Feen, Hexen und ähnliche Wesen, die durch beispielsweise Zaubern eine Verbindung zwischen dem Jenseits und dem Diesseits herstellen, normal. Mit dem Laufe der Zeit verblasst die Freude für Märchen. Die Verbindung zwischen dem Diesseits und dem Jenseits wird ausgeknipst. Da tragen natürlich unsere Bildungseinrichtungen einen gehörigen Beitrag zu, da diese sehr naturwissenschaftlich geprägt sind. Phänomene aus dem Jenseits, die mechanistische Auswirkungen im Diesseits haben sind nicht Bestandteil der Lehrpläne. Diese gibt es aber. Nehmen Sie das Beispiel des Besprechens von Hautflechten. Sicherlich fallen Ihnen eine Reihe weiterer ein. Im Laufe der Entwicklungszeit haben die Menschen der modernen Kulturen sich also entsöhnt und haben sich entweder auf die Seite des Materialismus geschlagen, die von naturwissenschaftlichen Erklärungsmodellen beherrscht wird, um rational Phänomene des Diesseits zu untersuchen oder eben auf die Seite des Idealismus, die von humanistischen Denkmodellen besetzt ist, um emotional Phänomene des Jenseits zu erklären. Nur wo ist die Brücke?

Das eine solche Versöhnung grundsätzlich nicht abwegig ist, zeigen uns die Anfänge des menschlichen Denkens, was wohl in das 6. Jh. v. Chr. zurück reicht. In dieser Zeit, die von die Milesiern geprägt war, und solche Denker wie Thales oder Anaximander prägten, gab es noch keine Unterscheidung zwischen lebender und toter Materie. Alles wurde als lebend gesehen, selbst ein Magnet, da er ja Eisen anzieht und, das ohne Zutun von Menschen.

Eine Versöhnung ist also notwendig und auch möglich. Sie kann durch die Kybernetik vorangetrieben werden. Ist sie denn schon vollzogen?

Die Versöhnung: Der Vollzug

Leider noch nicht. 2 fortschrittliche Denker bestärken mich in diesem Fazit: Gotthard Günther und Heinz von Foerster.

Gotthard Günther betonte immer wieder den Fakt, dass in den Naturwissenschaften erkannt wurde, und zwar seit Einstein und Heisenberg mit der Relativitätstheorie und der Quantenphysik, dass es nicht mehr nur ausreicht sich in den Untersuchungen und Forschungen auf die tote Materie zu stürzen. Diese Erkenntnis wurde aber nicht zu Ende gedacht. Denn, es wurde zwar die Subjektivität eingebunden, aber eben nur genau eine. Dadurch beruhen alle Untersuchungen nur auf genau eine Kontextur. Die eingebundene Subjektivität wurde also quasi objektiviert, was nicht zum Ziel führen kann. Das hat Günther erkannt, in dem er die Polykontexturalität erfunden und eingeführt hat.

Heinz von Foerster, einer der Väter und auch Teilnehmer der oben angesprochenen Macy-Konferenzen, hat stets dafür plädiert von dem Separieren von Wissenschaftsgebieten weg zu kommen hin zu einer Untersuchung der Zusammenhängen von verschiedenen Wissenschaftsgebieten. Science kommt vom griechischen Wort Ski und bedeutet so viel wie Separieren. Dieses Separieren hat früher wahrscheinlich auch Sinn gemacht, in dem man tiefer in verschiedene Gebiete einsteigen musste, um diese zu verstehen: Mathematik, Physik, Biologie, Chemie, Psychologie etc. So entstanden die Wissenschaften und Generalisten wurden zu Spezialisten. Dabei wurde aber das Verschmelzen der Erkenntnisse vergessen oder auch teilweise unmöglich, da die einzelnen Wissenschaften ihre eigenen Sprachen entwickelt haben, die eine Kommunikation erschweren. Wir benötigen wieder Generalisten, die diese Kommunikation herstellen und unterstützen. Diese Generalisten könnten Kybernetiker sein. Maria Pruckner hat in ihrem Film 90 Jahre Heinz von Foerster das Leben und das Wirken von Foersters sehr anschaulich nachgezeichnet.

(2 Bewertung(en), Durchschnitt: 5.00 von 5)

(2 Bewertung(en), Durchschnitt: 5.00 von 5)

Loading...

Loading...