Ich habe in meinem Post Der Business Intelligence Wirkkreis den BI Wirkkreis vorgestellt. Um diesen Rahmen rankt sich das Agieren in einem Unternehmen. Die dort aufgeführten Fragen müssen regelmäßig beantwortet werden und die visionär-strategische Ebene muss in periodischen Abständen validiert werden. Dafür müssen Entscheidungen getroffen werden. Darum geht es in diesem Post, um Entscheidungsprozesse. Ich möchte “Entscheiden an sich” näher beleuchten, möchte den Begriff definieren, die Bedeutung und die Schwierigkeiten herausarbeiten und System Dynamics als Kommunikationsmittel für Entscheidungsprozesse in Unternehmen begründen.

Bevor ich aber loslege möchte ich auf eine Konferenz hinweisen. x mess heißt diese Konferenz zur [nächsten] Gesellschaft und findet vom 17. bis 19. November 2011 in Berlin statt. Die Veranstaltung des mz-x widmet sich 3 Tage dem Fragenkomplex: Wie müssen Organisationen (heute) im Kontext einer nächsten – vom Computer geprägten Gesellschaft – gedacht, entworfen, beraten und letztendlich auch gemanagt und geführt werden? Im Vorfeld dieser Konferenz gibt es eine Blogparade, die aktuelle Überlegungen zum oben aufgeführten Fragenkomplex aufgreifen soll. An dieser nehme ich mit diesem Post teil.

Also los geht’s. Auf eine eifrige Diskussion.

Was verstehen wir unter Entscheiden in Unternehmen?

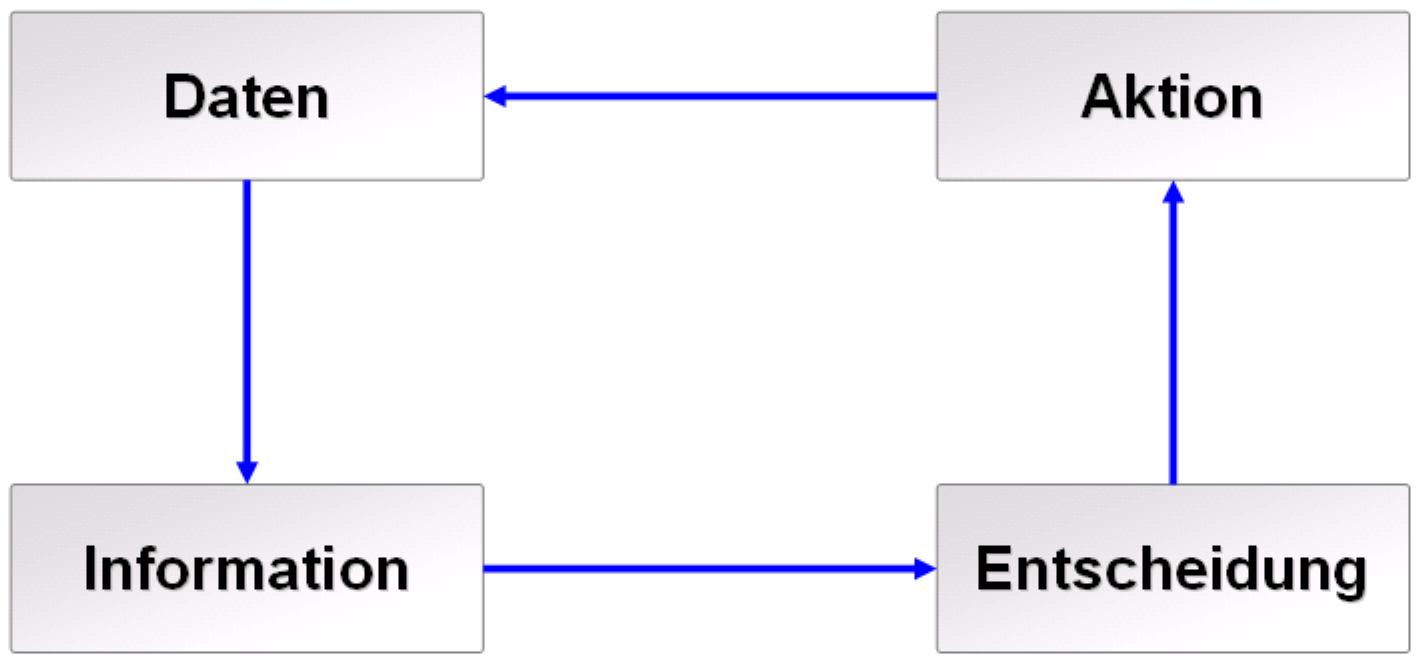

Entscheiden bedeutet, Daten zu sammeln, diese in Informationen umzuwandeln und dann daraus Handlungsanweisungen zu definieren, die Basis für Aktionen in Unternehmen sind. Der Erfolg ist also abhängig davon, wie schnell und welche Daten ausgewählt werden. Des Weiteren ist Wissen und Erfahrung des Entscheiders notwendig, diese Daten in Information umzuwandeln, wobei angemerkt werden muss, dass Wissen und Erfahrung auch entscheidend sind, die richtigen Daten zu selektieren. Diese Information ist dann Grundlage für Handlungsanweisungen des Entscheiders. Das weltweite Datenvolumen wächst exponentiell. Die alltägliche Datenflut resultiert aus den operativen Systemen des Unternehmens oder den neuen Online-Quellen (Foren, Blogs, Twitter, Podcasts). Das macht das “richtige” Selektieren von Daten durch die Entscheider natürlich nicht einfacher, ganz im Gegenteil.

Welche typischen Entscheidungsmuster existieren?

Sehr häufig beobachte ich das Phänomen, dass Entscheidungen durch Manager und Führungskräfte, aber auch generell von Mitarbeitern, aufgeschoben werden. In der Regel wird das damit begründet, dass noch mehr Daten benötigt werden. Dieses Verhalten birgt aber Gefahren für die Handlungsfähigkeit des Unternehmens. Wir werden niemals die Situation erreichen können, alle Daten, die für eine Entscheidung notwendig sind, zu besitzen. Auf der einen Seite ist das rein ökonomisch nicht möglich. Auf der anderen Seite könnten wir die Frage nach Vollständigkeit niemals beantworten. Des Weiteren können wir gar nicht nicht entscheiden. Auch wenn wir nicht zu entscheiden glauben, entscheiden wir, dann allerdings mit weit mehr negativen Implikationen, da keine bewussten Handlungen definiert werden.

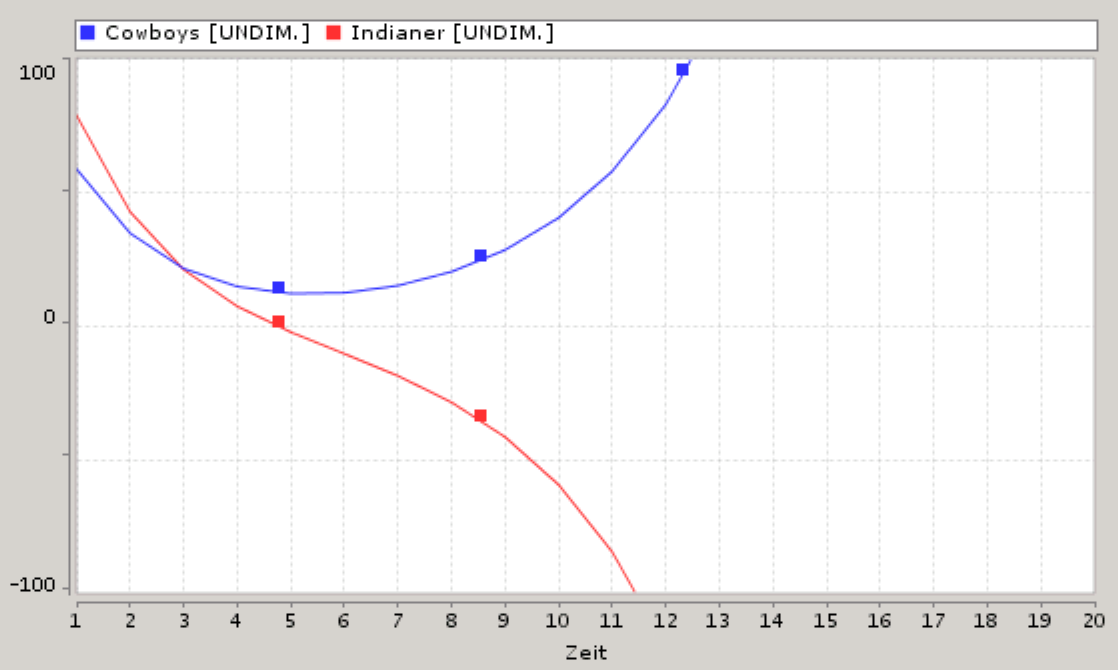

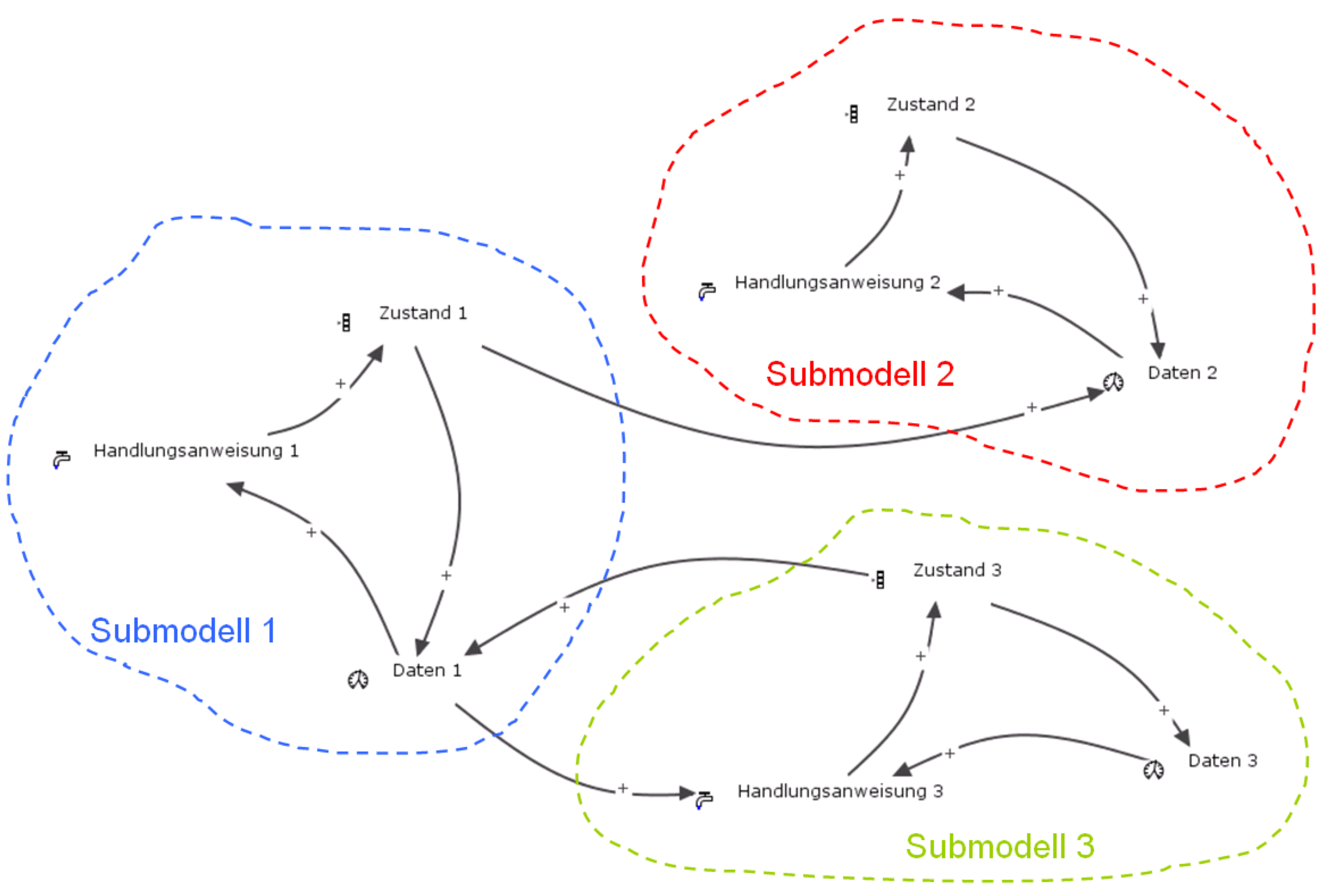

An dem zirkulären nichtlinearen Entscheidungsprozess der neben stehenden Abbildung erkennen wir den oben beschriebenen Ablauf von Entscheidungsprozessen. Durch das Ausführen von Aktionen werden Daten gewonnen und müssen selektiert werden und in Information umgewandelt werden, um daraus Handlungsanweisungen zu generieren, die dann wieder in Aktionen münden, die dann wiederum zu Daten führen… Es ist einleuchtend, dass für jeden Schritt des Entscheidungsprozesses eine gewisse Zeit benötigt wird. Die wohl größten Herausforderungen, mit denen Entscheider umgehen müssen, sind zum einen die Nichtlinearität, die aus der Feedbackschleife von Aktion zu Daten entsteht und die eben angesprochenen Verzögerungen. Das ist auch der entscheidende Grund, warum System Dynamics als Kommunikationsmedium für Entscheidungen so gut geeignet ist. Dazu komme ich aber noch. Erst einmal möchte ich auf die beiden Komplexitätstreiber eingehen.

Was macht Entscheiden so komplex?

Die immer größer werdende Vernetzung unserer Gesellschaft, lässt auch die Wirtschaftswelt nicht unbetroffen. Die beiden prägnanten Phänomene Nichtlinearität und Verzögerung möchte ich an praxisnahen Beispielen erklären und veranschaulichen. Starten wir mit der Nichtlinearität.

Stellen Sie sich vor, Sie könnten ein Blatt Papier 48 mal falten. Was denken Sie, wie hoch der Papierstapel wäre? Das Ergebnis hat mich verblüfft und ich hätte es ohne Berechnung nicht erahnen können. Das ich ein Blatt Papier 48 mal falte, kann ich mir noch rein theoretisch vorstellen. Das ich dann aber einen Stapel erzeuge, der 28 Mio. km hoch ist, entzieht sich meiner Vorstellungskraft. Jetzt stellen Sie sich vor, mehrere nichtlineare Ursache-Wirkungsbeziehungen dieser Art sind in einer Problemlage, wie die derzeitige Gesellschaftskrise, die durch den Zinseszins erzeugt wird, enthalten. Ist es da noch verwunderlich, dass die wahren tiefliegenden Ursachen nicht erkannt werden, sondern nur Symptombekämpfung stattfindet, wie es die derzeitige Diskussion über den EU-Rettungsschirm für Banken wieder einmal zeigt? Ich habe die oben besprochene Fragestellung des Papier Stapelns mit dem CONSIDEO MODELER modelliert.

Ein weiteres Beispiel möchte ich nicht unerwähnt lassen, da es uns spätestens dann betrifft, wenn wir ein Haus bauen oder kaufen möchten und dieses finanzieren müssen. Stellen Sie sich vor Sie müssen eine Kreditsumme von 180.000 Euro aufnehmen und bekommen dafür einen Zinssatz p.a. von 4,6%. Wenn Sie jetzt monatlich 800 Euro einzahlen, benötigen Sie 42!! Jahre, um die Kreditsumme komplett zu tilgen. Dabei haben Sie nach 30 Jahren erst die Hälfte!! getilgt und ihre Gesamtkosten belaufen sich auf 403.000 Euro!!. Sie haben also für ihr Haus mehr als den doppelten realen Wert!! bezahlt. Das ist der Zinseszinseffekt, der unsere Gesellschaft in eine Krise stürzt. Die Effekte bzgl. der Hausfinanzierung können Sie in diesem CONSIDEO Modell simulieren.

Kommen wir zum zweiten Phänomen, den Verzögerungen. Verzögerungen erzeugen den so genannten Bullwhipeffekt, ein Aufschaukeln des Systems. Dieses Aufschaukeln kommt zu Stande, weil zu spät auf Einflüsse der Umwelt reagiert und dies deshalb zu stark erfolgt. Ich habe in meinem Post Mit System Dynamics Dynamiken und Verzögerungen von Handlungen verstehen das Beispiel des Einstellens der Wassertemperatur beim Duschen angeführt. Ich möchte ein weiteres anmerken. Stellen Sie sich vor, Sie sind Führer eines PKWs und fahren mit verbundenen Augen. Sie haben 3 Insassen, die sich wie in einer Kette aufgezogen, die Nachricht übermitteln, wohin sie lenken sollen. Das kann wie folgt ablaufen. Der Insasse hinten links beobachtet, wo sie lang fahren und übermittelt die Steuerinformationen an seinen Nachbarn hinten rechts, dieser gibt diese Nachrcht an Ihren Beifahrer vorne, der Ihnen diese dann mitteilt. Das “Stille Post” Phänomen wollen wir hier mal ausschließen. Sie als Fahrer bekommen also genau die Information von Ihrem Beifahrer übermittelt, die der Insasse hinten links initial abgesetzt hat, aber eben verzögert. Man kann sich relativ leicht vorstellen was ein externer Beobachter bzgl. ihrer Fahrspur wahrnehmen würde. Eine Wellenlinie von links nach rechts nach links usw. bis sie irgendwann ein Gespür für die Verzögerungen entwickelt haben und die Wellenlinien immer kleiner werden bis Sie vielleicht irgendwann eine gerade Fahrspur relativ zur Straßenführung erreicht haben. Sie befinden sich dann im Fließgleichgewicht. Diese Wellenlinie kann man auch bei einer Supply Chain mit mehreren Beteiligten beobachten: Kunden, Einzelhandel, Großhandel, Lieferant und Fabrik. Je mehr Beteiltigte existieren, desto größer ist der Bullwhipeffekt. Es versteht sich von selbst, dass ich Sie nicht ermutigen möchte, den Bullwhipeffekt durch das Führen eines PKW mit verbundenen Augen praktisch nachzuvollziehen.

Die Schwierigkeit beim Umgang mit Verzögerungen besteht also darin, dass die Auswirkungen einer getätigten Handlung erst später ersichtlich sind. In der Regel kennt man die Verzögerung nicht. Das bedeutet, die Fragestellung, auf die Auswirkungen zu warten oder bereits Gegenmaßnahmen zu entwickeln, sind schwierig zu beantworten.

Den Herausforderungen des Entscheidens kann man nicht aus dem Wege gehen, in dem man nicht mehr entscheidet. Denn nur in einem “toten Unternehmen” muss nicht mehr entschieden werden und wird es auch nicht mehr getan. Auch keine Entscheidung ist eine Entscheidung, meist ist diese dann schlechter, als wenn man bewusst entschieden hätte. Aber das hatten wir ja schon. Entscheiden heißt stets das Antizipieren des zukünftigen Geschehens. Es besteht also immer ein Risiko, das das Ergebnis des Antizipierens nicht mit dem real wahr genommenen Resultat übereinstimmt, da es zum Zeitpunkt des Entscheidens immer viele mögliche Zukünfte gibt, die erst mit den Aktionen zu genau einer Zukunft werden, die dann die Gegenwart des neuen Entscheidungsprozesses wird. Das Muster des Aussitzens von Entscheidungen haben wir oben bereits besprochen. Die wahr genommene Komplexität des Entscheidens führt dazu, dass sich Manager auf implizite Entscheidungen zurückziehen, die eigentlich nicht entschieden werden müssen, sondern die sich aus der Situation von ganz alleine ergeben. Dazu möchte ich ein Zitat des Kybernetikers Heinz von Foerster anführen.

Nur die Fragen, die prinzipiell unentscheidbar sind, können wir entscheiden.

Für diese Entscheidungen, benötigen wir aber keine Menschen. Es ist also wichtig zwischen offenen und impliziten Entscheidungen zu differenzieren. Offene Entscheidungen sind bewusste freie menschliche Entscheidungen (Auf die philosophische Diskussion von Freiheit im Handeln möchte ich in diesem Post nicht tiefer eingehen), die bei prinzipiell unentscheidbaren Fragestellungen, um mit von Foersters Worten zu sprechen, anzuwenden sind. Implizite Entscheidungen sind systembedingt unaufhaltsam und geschehen definitiv. Ein Beispiel für eine offene Entscheidung durch das Management eines Unternehmens ist das Bestellen von Material oder das Einstellen von Mitarbeitern, um letztendlich die Produktionsrate zu steuern. Hier ist also das Bestimmen der Produktionsrate eine implizite Entscheidung, da sie systembedingt ist. Die Grenze zwischen offenen und impliziten Entscheidung ist sehr oft schwammig. Diese Grenze muss aber bei der Betrachtung von Situationen beachtet werden, da sie klar herausstellt, wo eingegriffen werden kann und welche Ergebnisse systemimmanent sind. Man könnte sich genauso gut vorstellen, dass das Einstellen von Mitarbeitern eine implizite Entscheidung ist, die von anderen Faktoren abhängt, wie beispielsweise der Reputation des Unternehmens. Man muss also beim Entscheiden stets zwischen Anliegen und Tatsachen unterscheiden. Offene Entscheidungen birgen ein Dilemma für Führungskräfte, da sie zum Zeitpunkt des Treffens dieser kein “richtig” oder “falsch” kennen. Das stellt sich erst später mit den Ergebnissen der daraus abgeleiteten Aktionen heraus.

Wir kennen nun die Komplexitätstreiber im Rahmen von Entscheidungen. Manager benötigen eine Methode, um diese Komplexitätstreiber zu handhaben. Meiner Meinung nach ist System Dynamics hervorragend dafür geeignet. Das erkläre ich folgend.

Wie kann System Dynamics beim Entscheiden unterstützen?

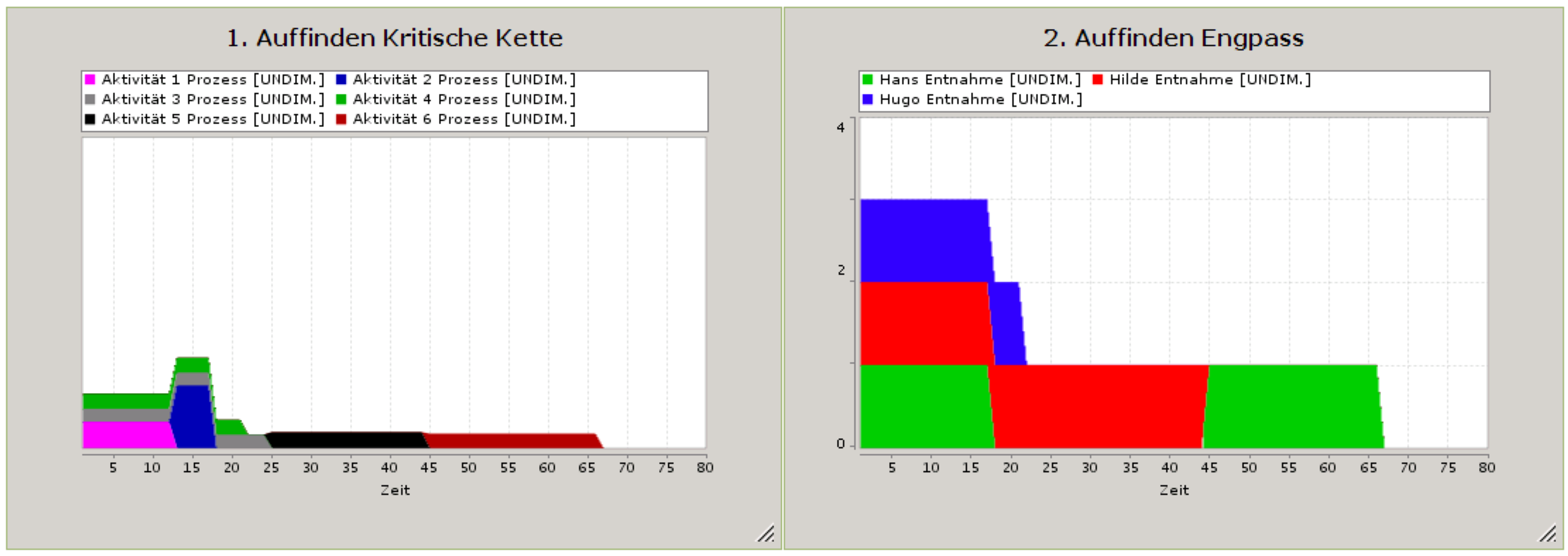

In meinem Rucksack finden Sie unter Systemtheorie und Modellierung Grundlagen zur qualitativen und quantiativen Modellierung, speziell System Dynamics. In diesem Post möchte ich System Dynamics speziell für Entscheidungsprozesse in Unternehmen beleuchten.

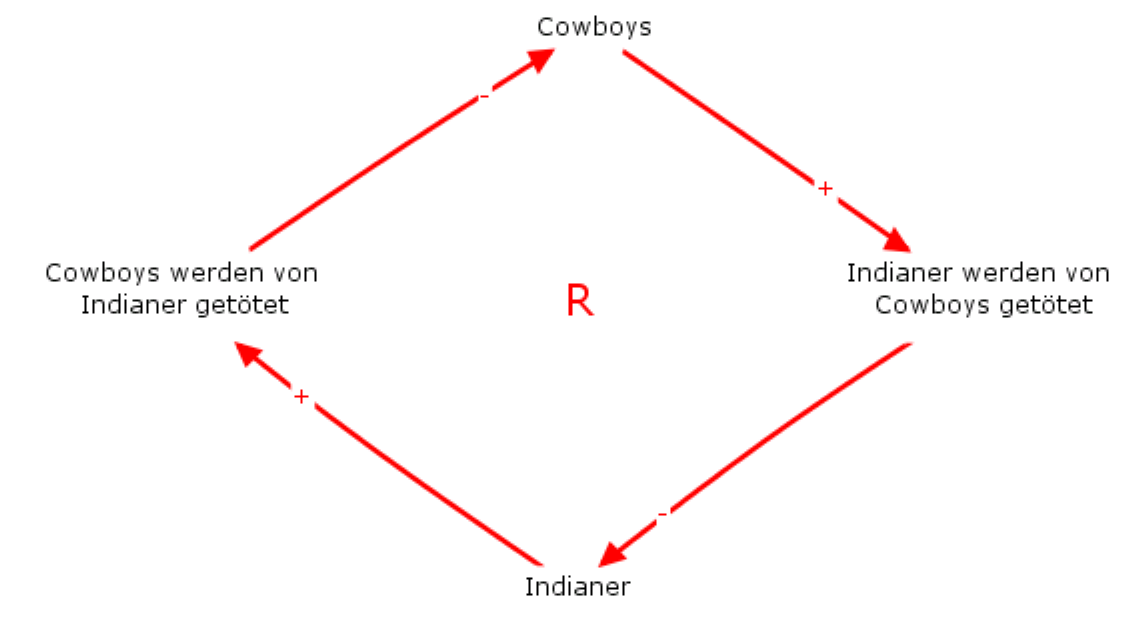

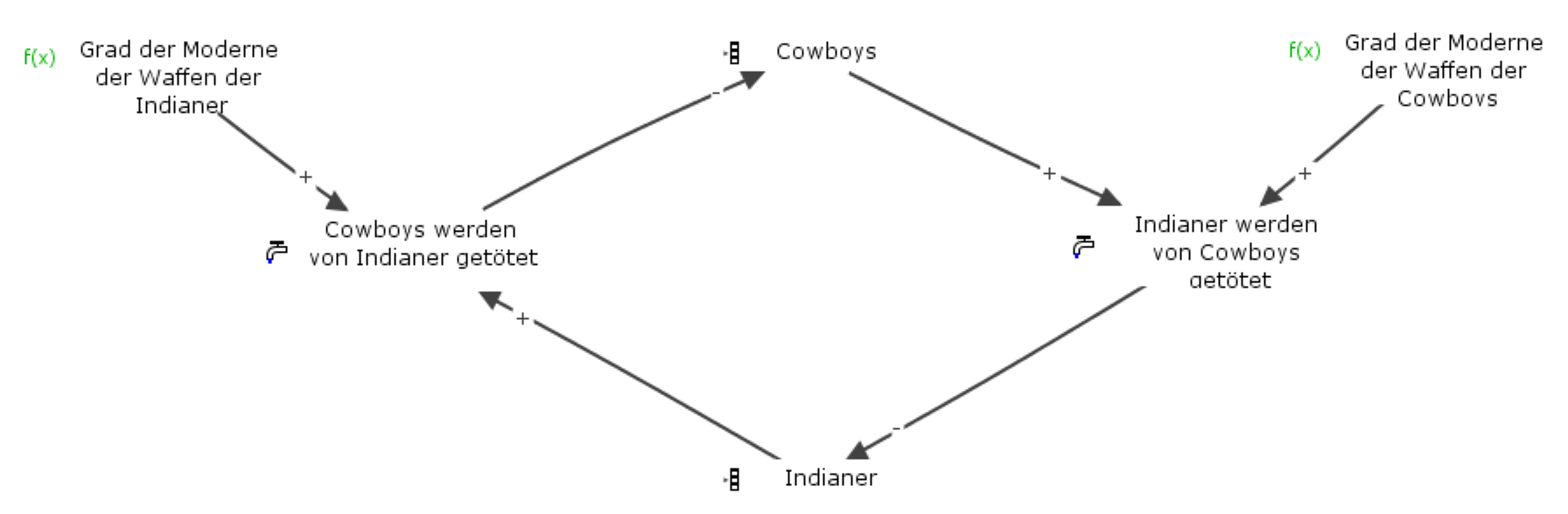

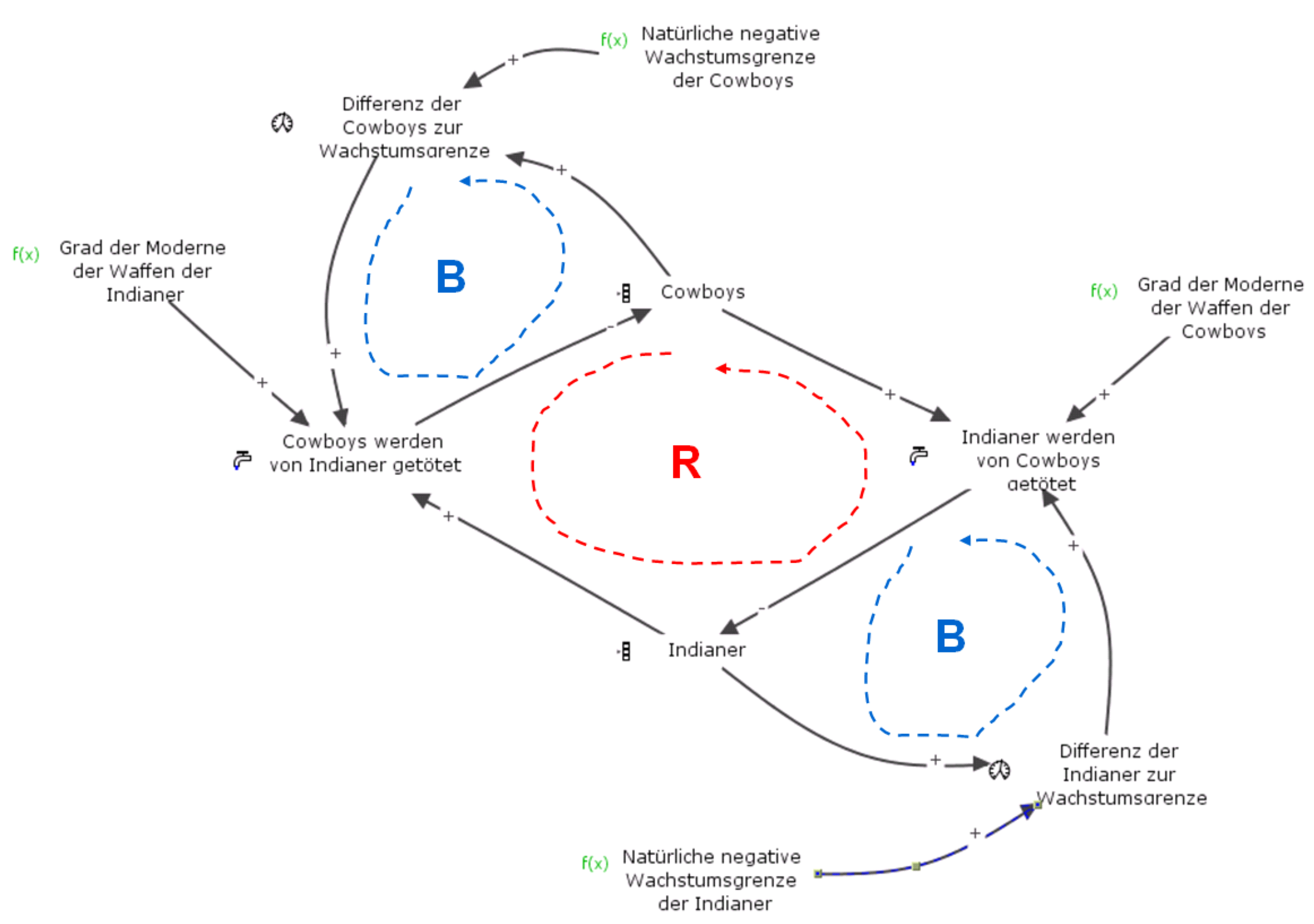

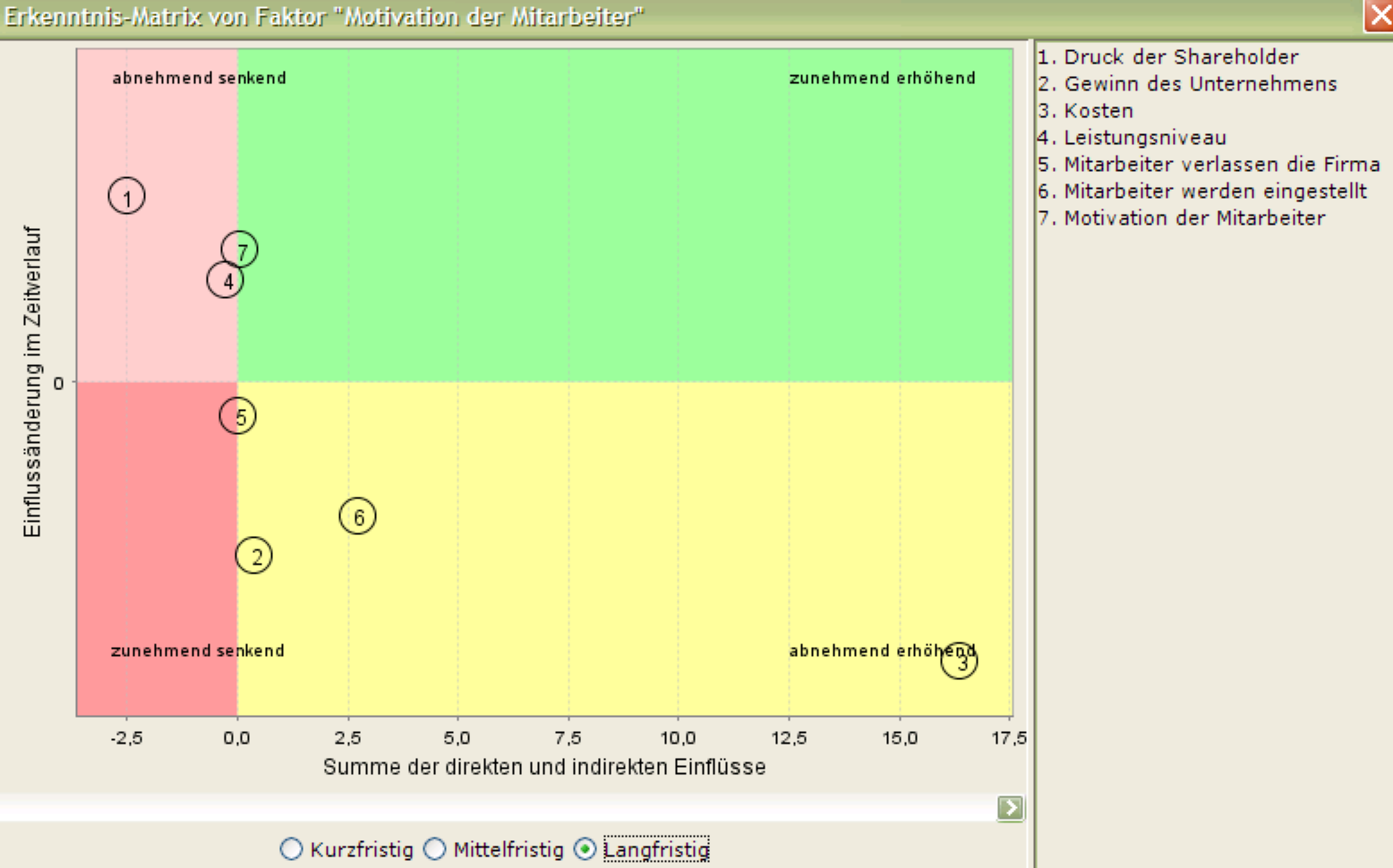

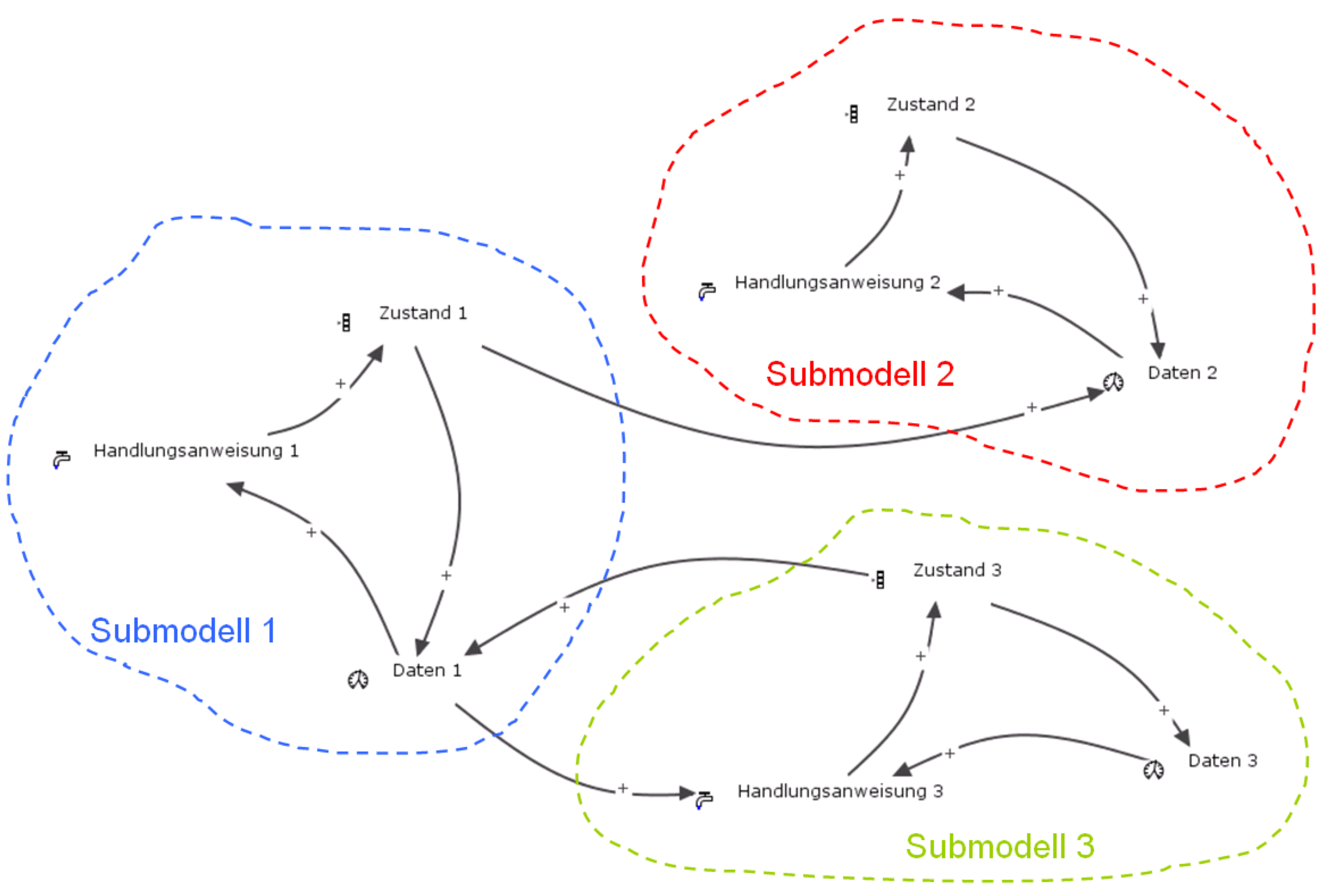

In der obigen Abbildung erkennen Sie grundsätzlich die verschiedenen Faktoren einer System Dynamics Modellierung: Bestandsfaktoren, Flussfaktoren und Hilfsfaktoren. Die Bestandsfaktoren “Zustand …” zeigen die jeweilige Güte eines Systems. In der Vergangenheit haben mich sehr viele Fragen erreicht, die stets darauf abzielten wie und woher man erkennt, welche Faktoren Bestandsfaktoren sind. Ich antworte dann immer wieder, dass dies abhängig von dem Zweck der Modellierung ist. Das möchte ich am Beispiel Fußball erklären. Stellen Sie sich vor, sie sind Manager eines Bundesligavereins und möchten ihre Entscheidungen mit System Dynamics modellieren und simulieren. Nehmen wir einmal an, sie fokussieren sich auf die derzeitige Saison und setzen alles daran Meister zu werden. Ein möglicher Bestandsfaktor könnte dann die Punktzahl sein, da diese sich von Spiel zu Spiel akkumuliert. In der nächsten Saison allerdings muss dieser Bestandsfaktor wieder auf Null gesetzt werden, da die erreichten Punkte ja nicht mit in die neue Saison übernommen werden können. Es exisitieren aber Faktoren, die wichtig für den Erfolg sind, und die mit in eine neue Saison übernommen werden. Das sind zum Beispiel Teammoral oder Erfolgshunger. Vernachlässigen Sie diese Faktoren in ihrer Modellierung erkennen sie nicht, dass sich beispielsweise der Gewinn einer Meisterschaft negativ auf den Erfolgshunger einer Mannschaft in der neuen Saison auswirken kann. Es klingt paradox. Aber manchmal ist es für die langfristige Entwicklung einer Mannschaft schädlich, unerwartet und überraschend Meister zu werden. Nehmen Sie das Beispiel Wolfsburg. Wenn Sie also als Manager einer Fußballmannschaft den langfristigen Erfolg im Auge haben, müssen Sie die Kurzfristsicht (Meister in dieser Saison werden) stets mit der Mittel- und Langfristsicht (Moral, Ehrgeiz, Zusammenhalt) in Einklang bringen. Für diese Mittel- und Langfristsicht wären dann also auch die 3 in Klammern angesprochenen Faktoren Bestandsfaktoren, die im Modell berücksichtigt werden müssen.

Bestandsfaktoren speichern stets die Historie eines Systems. Sie lassen sich deshalb nur über einen Zeitverlauf ändern. Beispielsweise können Sie nicht von jetzt auf gleich eine Wanne mit Wasser füllen oder Sie werden es nicht von jetzt auf gleich schaffen ihre Mitarbeiter zu motivieren. Dafür benötigen Sie Zeit, die eingeplant werden muss.

Ich habe ein Plansimulationsspiel in Bezug auf Fußball erstellt, in welchem Entscheidungen im Hinblick auf den Erfolg einer Mannschaft simuliert werden können. Dieses können Sie im Consideo Shop käuflich erwerben. Detaillierte Informationen finden Sie hier.

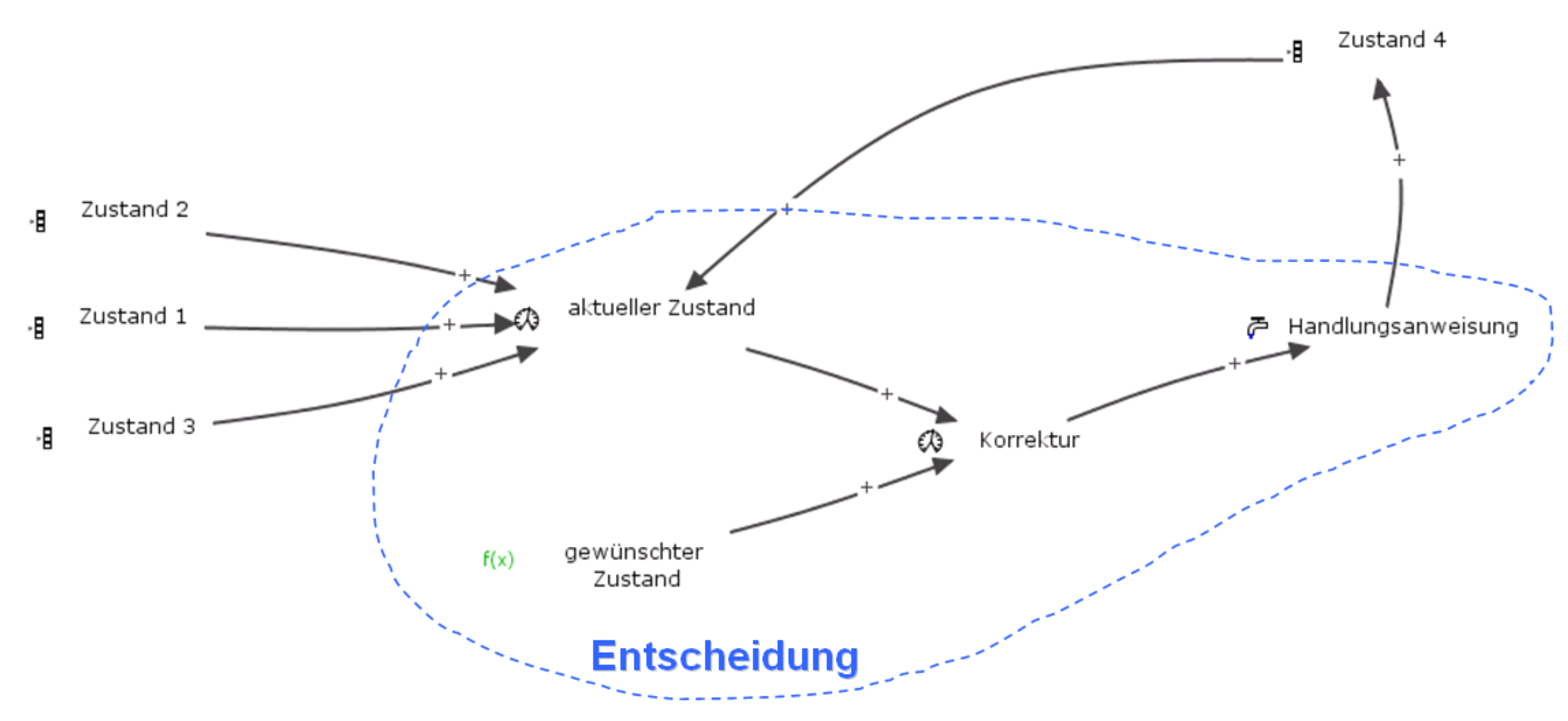

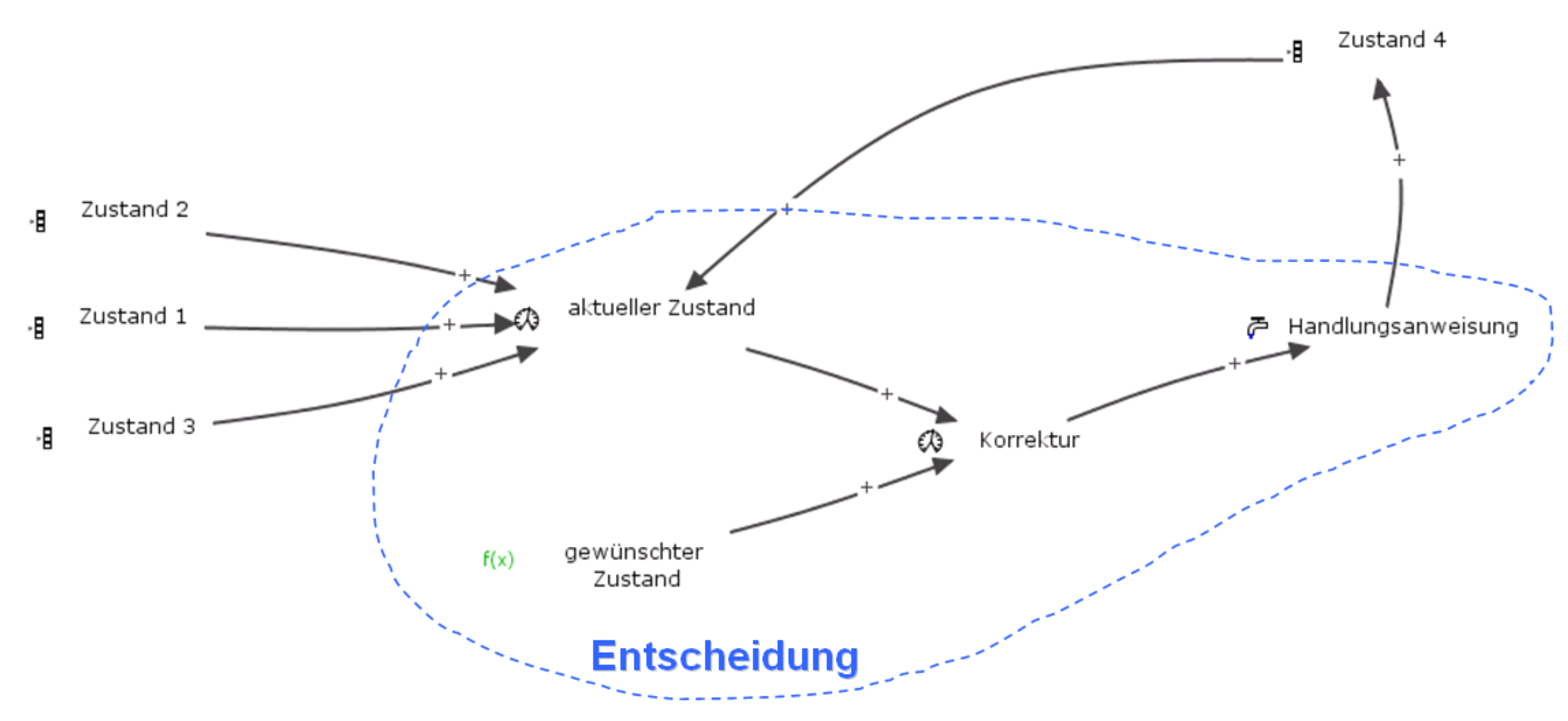

Ich modelliere stets für jeden Bestandsfaktor ein separates Submodell, wie in der obigen Abbildung auch dargestellt. Des Weiteren stellen die Flussfaktoren die jeweiligen Handlungsanweisungen und Aktionen dar. Nur aus diesen ergeben sich neue Zustände eines Systems, sprich die Bestandsfaktoren ändern sich. Beeinflusst werden die Handlungsanweisungen durch die Daten, die zu Informationen transformiert werden müssen. Aus diesem Blickwinkel betrachtet, sieht es noch ein wenig mechanistisch aus. Deshalb möchte ich in den wichtigsten Part der Modellierung hineinzoomen, nämlich in den Akt der Handlungsanweisung. In der nächsten Abbildung erkennen Sie genau ein Submodell, in dem es grundsätzlich darum geht, ein bestimmtes Zustandselement (Bestandsfaktor “Zustand 4”, beispielsweise Moral) zu verändern.

Ich möchte auf den Flussfaktor “Handlungsanweisung” zu sprechen kommen. Mithilfe von Flussfaktoren lassen sich grundsätzlich die Verfahrensweisen von Entscheidungen abbilden, sprich wie Daten zu Informationen und schließlich zu Aktionen ungewandelt werden. An dieser Stelle muss also in Betracht gezogen werden, dass es Menschen sind, die Entscheidungen treffen und dass diese Menschen dabei klar definierte Regeln befolgen, die aber ohne Modellierung nicht offen gelegt werden. In diesem Entscheidungsprozess, der in der obigen Abbildung blau eingerahmt ist, spielt das Ziel, der gewünschte Zustand, sowie der momentan aktuelle Zustand des Bestandsfaktors eine Rolle. Ausgehend von der Differenz der beiden letzt Genannten wird dann eine Handlungsanweisung definiert. In Form von mathematische Anweisungen, Formeln oder Tabellenbeziehungen, zu den Flussfaktoren lassen sich dann die Verfahrensanweisungen definieren, die letztendlich zu Entscheidungen führen. Die Faktoren “aktueller Zustand”, “gwünschter Zustand” und “Korrektur” sind so genannte Hilfsfaktoren und gehören strukturell zu den Flussfaktoren, da sie den Input für diese liefern. Für die Berechnung von Entscheidungen in Form der Flussfaktoren ist es unerlässlich, Daten zu haben. Diese Daten speisen sich stets aus den Bestandsfaktoren, sprich aus den derzeitigen Zuständen des Systems. Das erkennen Sie in der obigen Abbildung an den Inputs in den Faktor “aktueller Zustand”. Beispiele für Verfahrensweisen, die in den Formeln von Flussfaktoren hinterlegt werden, sind

- Ab welchem aktuellen Lagerbestand unter Zuhilfenahme der Information des durchschnittlichen Verkaufs eines Produktes muss ein Einzelhändler Produkte vom Großhändler bestellen und wieviel?

- Wieviel Mitarbeiter müssen in einem bestimmten Monat eingestellt werden, um eine vorher definierte Zielauslastung zu erreichen? Dabei können die derzeit laufenden Projekte und die anstehenden Projekte in der nahen Zukunft mit in Betracht gezogen werden.

Sehr oft habe ich die Kritik bzgl. des Modellierens gehört, dass Verfahrensweisen für Handlungsentscheidungen nicht in mathematische Formeln gepackt werden können und deshalb das Modellieren keinen Mehrwert besitzt. Dem muss ich dann immer entgegnen, dass egal ob man explizit ein Modell mit System Dynamics erstellt oder nicht, der Entscheider immer ein Modell für seine Entscheidungen zu Grunde legt. Sonst könnte er gar nicht bewusst entscheiden. Der Vorteil eines expliziten System Dynamics Modells ist, dass es als Kommunikationsgrundlage dient und dass es möglich ist, im voraus bestimmte Szenarien zu simulieren ohne das man reale und dann vielleicht negative Ergebnisse erhält. Mit einem System Dynamics Modell wird man natürlich niemals simulieren können, wieviel Umsatz mit welchem Kunden im nächsten Monat erzielt wird. Das kann auch nicht der Anspruch sein. Beim Modellieren geht es eher um das Aufspüren von Verhaltensmuster im System, auf die man dann reagieren kann.

Aufgrund dessen, dass sich die Welt ändern kann aber auch dass sich unsere Sicht auf die Welt ändern kann, das sind zwei verschiedene Sachen, ist ein Modell niemals fertig. Das Modell muss stets valdiert werden, weil Sie beispielsweise die Ziele geändert haben, weil Sie neue Daten vorrätig haben, weil neue mentale Modelle für die Transformation der Daten in Informationen bestehen, weil neue Richtlinien hinsichtlich von Entscheidungsprozessen bestehen und so weiter und so fort. Entscheidungen, die Ergebnisse der Formeln in den Flussfaktoren sind, sind also abhängig von den “beobachteten” Ergebnissen. Diese können aber mit den “realen” Zuständen des Systems differieren. Gründe dafür sind die Verzögerungen in Veränderungen eines Systems und das nicht “Glauben wollen” oder das falsche Interpretieren von Bedeutungen, die sehr häufig aus Nichtlinearitäten entstehen. Diese Effekte müssen dementsprechend in ein Modell integriert sein.

System Dynamics ist eine Methode und ein Kommunikationsmedium, bei der man von dedizierten Problemsituationen ausgeht, daraus Strukturen und Muster entwickelt, unerwünschte Symptome zu verstehen und daraus dann mögliche Handlungsalternativen ableitet, um dieses negativen Verhalten zu eliminieren.

Was müssen gute Entscheider beherrschen?

Eines gleich vorweg. Ich behebe bei der kommenden Auflistung keinen Anspruch auf Vollständigkeit. Sie können über die Möglichkeit der Kommentare gerne ergänzen. Eines ist, so hoffe ich doch, ersichtlich geworden: Ohne Kenntnis von System Dynamics bleibt Entscheiden ein Stochern im Nebel ohne eine Basis für das Lernen zu kreieren. System Dynamics erlaubt kein Vorhersagen von zukünftigem Geschehen. Mit System Dynamics kann man in der Gegenwart mögliche verschiedene Zukünfte anhand von Szenarien simulieren, die dann Basis für Entscheidungen sind. Tritt dann diese Zukunft nicht ein, sprich war die Entscheidung falsch, was man wie oben schon angedeutet immer nur im nachhinein validieren kann, kann man anhand der Parameter und der Prämissen des Modells die Ursache dafür eruieren. Man erzeugt also ein Plattform, die es erlaubt über Probleme im Unternehmen zu kommunizieren und zu lernen.

Ungemein wichtig ist es aber, dass System Dynamics als Methode und Kommunikationsmittel in eine adäquate Umgebung eines Unternehmens eingebettet ist, damit sie fruchtbar gemacht werden kann. Eine proaktive Fehlerkultur muss im Unternehmen etabliert sein. Entscheiden heißt Fehler machen, da man viele mögliche Zukünfte auf genau eine eindampft. Werden Mitarbeiter für Fehler sofort abgestraft, werden Entscheidungen ausgesessen. Was dann passiert haben wir oben besprochen. Ist ein Unternehmen auf einem Kurzfristfundament gebaut, werden die verzögerten Auswirkungen von Entscheidungen per Gesetz negiert. Es darf sie dann nicht geben, weil sich getätigte Investitionen kurzfristig, bestenfalls im gleichen Quartal auszahlen müssen. Ein Hoch auf die Börse. Aber nur weil wir Menschen etwas nicht wollen, wird es deshalb nicht gleich nicht geschehen. Entscheider müssen also den Mut, Durchsetzungsstärke aber auch Argumentations- und Motivationsstärke besitzen, um solche Paradigmen zu kippen.

Des Weiteren sollten Entscheider weise und nicht nur wissend sein. Weise Entscheider fragen sehr häufig “Warum”, wissende Entscheider fragen dagegen bloß “Wie”. Um weise zu sein, muss man Wissen haben, aber Wissen alleine reicht nicht aus um weise zu sein. Der Weise fragt beispielsweise, was er eigentlich davon hat zu gewinnen. Der Wissende will stets gewinnen, ohne immer zu wissen was er davon hat. Weise sein bedeutet auch demütig gegenüber Fehler zu sein. Der Weise weiß, dass er nicht alles wissen kann. Er weiß, dass man die Effekte, die den Erfolg seiner Entscheidungen beeinflussen, nicht vollständig beherrschen kann. Der ausschließlich Wissende verallgemeinert zu schnell und denkt und agiert ausschließlich kurzfristig. Wissen steht für Wettbewerb, Weise sein für Kooperation. Weise nutzen gerne und stets ihren Kopf zum Denken. Wissende denken weniger, sondern nehmen lieber den Kopf anderer in dem sie auf vorgefertigte Lösungen und Best Practice vertrauen.

(Keine Bewertungen bislang. Geben Sie doch die erste ab.)

(Keine Bewertungen bislang. Geben Sie doch die erste ab.)

Loading...

Loading...